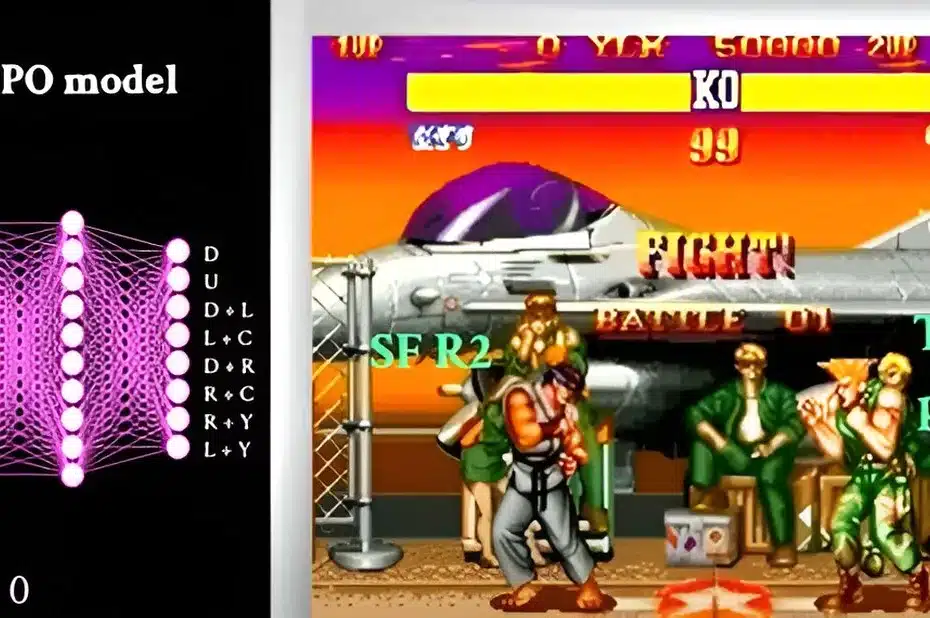

Pesquisadores da Universidade de Tecnologia e Design de Cingapura (SUTD) aplicaram com sucesso o aprendizado por reforço a um problema de videogame. A equipe de pesquisa criou um novo e complicado software de design de movimentos baseado em uma abordagem que se mostrou eficaz em jogos de tabuleiro como Chess and Go. Num único teste, os movimentos da nova abordagem pareceram superiores aos dos melhores jogadores humanos.

Essas descobertas poderiam impactar a robótica e a automação, inaugurando uma nova era no design de movimentos. O artigo da equipe na Advanced Intelligence Systems é intitulado “Um aprendizado de reforço memorativo de mudança de fase para jogadores campeões de Street Fighter com desempenho rápido”.

“Nossas descobertas demonstram que o aprendizado por reforço pode fazer mais do que apenas dominar simples jogos de tabuleiro . O programa se destacou na criação de movimentos mais complexos quando treinado para enfrentar desafios de longa data na ciência do movimento”, disse o investigador principal Desmond Loke, professor associado do SUTD.

“Se este método for aplicado aos problemas de investigação certos”, diz ele, “poderá acelerar o progresso numa variedade de campos científicos”.

O estudo marca um divisor de águas no uso da inteligência artificial para avançar nos estudos da ciência do movimento. As possíveis aplicações são inúmeras, desde o desenvolvimento de automóveis mais autônomos até novos robôs colaborativos e drones aéreos.

O aprendizado por reforço é um tipo de aprendizado de máquina no qual um programa de computador aprende a tomar decisões experimentando várias ações e obtendo feedback. Por exemplo, o algoritmo pode aprender a jogar xadrez testando milhões de movimentos possíveis que resultam em sucesso ou derrota no tabuleiro. O programa tem como objetivo ajudar os algoritmos a aprender com suas experiências e melhorar suas habilidades de tomada de decisão ao longo do tempo.

A equipe de pesquisa forneceu ao computador milhões de movimentos iniciais para criar um programa de aprendizagem por reforço para design de movimento. O programa então fez várias tentativas para melhorar cada movimento aleatoriamente em direção a um objetivo específico. O computador ajusta o movimento do personagem ou ajusta sua estratégia até aprender como fazer movimentos que superem a IA integrada.

O professor associado Loke acrescentou: “Nossa abordagem é única porque usamos o aprendizado por reforço para resolver o problema de criar movimentos que superam os dos melhores jogadores humanos. Isso simplesmente não era possível usando abordagens anteriores e tem o potencial de transformar os tipos de movimentos que nós podemos criar.”

Como parte de sua pesquisa, os cientistas criam movimentos para competir com várias IAs integradas. Eles confirmaram que os movimentos poderiam superar diferentes oponentes de IA integrados.

“Essa abordagem não é apenas eficaz, mas também eficiente em termos energéticos.” O sistema baseado em memória de mudança de fase, por exemplo, foi capaz de realizar movimentos com um consumo de energia de hardware de cerca de 26 fJ, o que é 141 vezes menor que o dos sistemas GPU existentes. “Seu potencial para fazer movimentos com energia de hardware ultrabaixa ainda não foi totalmente explorado”, afirmou o Prof. Associado Loke.

A equipe se concentrou na criação de novos movimentos capazes de derrotar os melhores jogadores humanos em um curto espaço de tempo. Isso exigiu o uso de algoritmos baseados em decaimento para criar os movimentos.

Os testes de algoritmo revelaram que os novos movimentos projetados por IA foram eficazes. Os pesquisadores observaram inúmeras boas qualidades como medida do sucesso do sistema de design, como etiqueta de jogo razoável, gerenciamento de informações imprecisas, capacidade de atingir estados de jogo específicos e os curtos tempos usados para derrotar oponentes.

Em outras palavras, o programa exibiu qualidades físicas e mentais excepcionais. Isso é conhecido como design de movimento eficaz . Por exemplo, os movimentos tiveram mais sucesso na superação dos oponentes porque a técnica baseada em decaimento usada para treinar redes neurais leva menos etapas de treinamento do que os métodos convencionais de decaimento.

Os investigadores vislumbram um futuro em que esta estratégia permitirá a eles e a outros construir movimentos, competências e outras ações que antes não eram possíveis.

“Quanto mais eficaz a tecnologia se torna, mais aplicações potenciais ela abre, incluindo a progressão contínua de tarefas competitivas que os computadores podem facilitar para os melhores jogadores, como no Poker, Starcraft e Jeopardy”, disse o Professor Associado Loke. “Também podemos ver uma competição realista de alto nível para treinar jogadores profissionais, descobrir novas táticas e tornar os videogames mais interessantes”.

Os pesquisadores do SUTD Shao-Xiang Go e Yu Jiang também contribuíram para o estudo.

Mais informações: Shao-Xiang Go et al, A Phase-Change Memristive Reinforcement Learning for Rapidly Outperforming Champion Street-Fighter Players, Advanced Intelligent Systems (2023). DOI: 10.1002/aisy.202300335