Pesquisadores da Universidade Carnegie Mellon desenvolveram uma ferramenta chamada EgoTouch, que utiliza inteligência artificial (IA) para controlar interfaces de realidade aumentada (AR) e realidade virtual (VR) através do toque na pele com um dedo. Essa nova tecnologia é descrita em um artigo publicado na “Proceedings of the 37th Annual ACM Symposium on User Interface Software and Technology” e foi criada no Instituto de Interação Humano-Computador da universidade. O objetivo do EgoTouch é possibilitar o controle de interfaces AR/VR sem a necessidade de dispositivos adicionais, utilizando apenas sensores presentes em headsets comuns dessas tecnologias.

A inspiração para o desenvolvimento do EgoTouch veio do OmniTouch, uma tecnologia anterior criada por Chris Harrison, professor associado do Instituto de Interação Humano-Computador e diretor do Future Interfaces Group. Embora o OmniTouch fosse promissor, ele necessitava de uma câmera de profundidade especial e volumosa. Já o EgoTouch utiliza uma abordagem inovadora: um algoritmo de aprendizado de máquina de IA que permite a câmeras comuns reconhecer o toque na pele, identificando deformações e sombras que ocorrem ao tocar a superfície da pele.

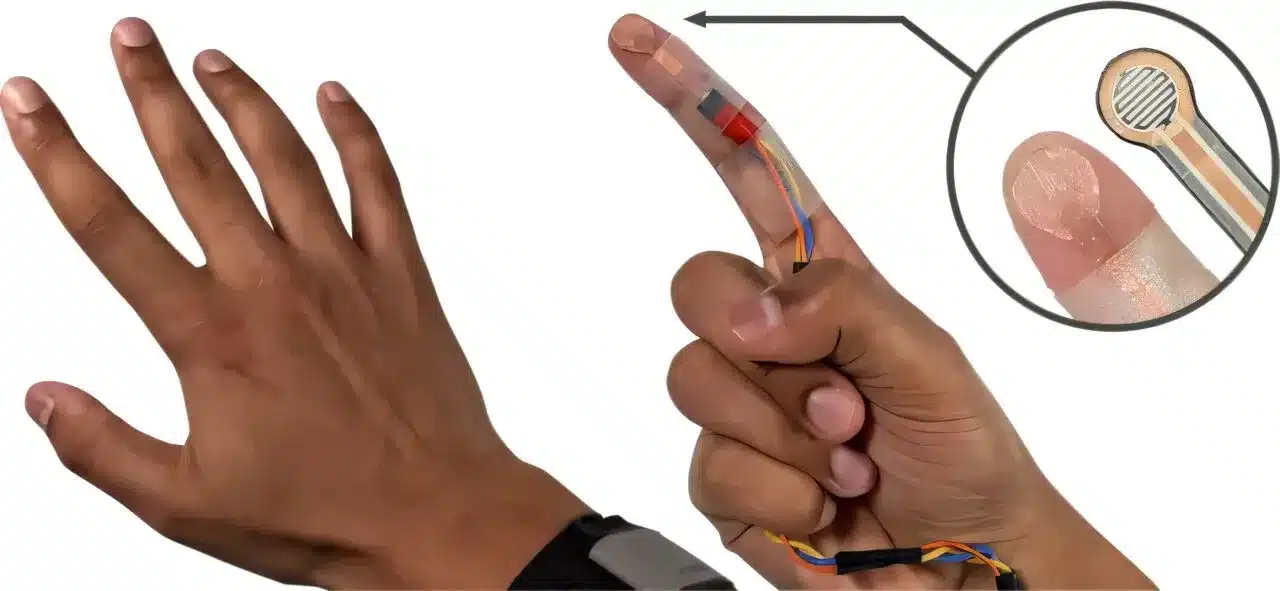

Para treinar o EgoTouch, Vimal Mollyn, doutorando orientado por Harrison, desenvolveu um sensor personalizado que coleta dados de diferentes tipos de toque com variadas intensidades. Esse sensor foi posicionado ao longo do dedo indicador e da palma da mão, permanecendo invisível para a câmera. Com base nos dados coletados, o modelo de IA aprendeu a associar as características visuais de sombras e deformações da pele ao toque e à força aplicada, sem a necessidade de anotações humanas.

A equipe ampliou o conjunto de dados, incluindo 15 usuários com diferentes tons de pele e densidade de pelos, e coletou horas de informações em diversas condições de luz e atividades. Com esse treinamento, o EgoTouch alcançou uma precisão de mais de 96% para detectar toques, com uma taxa de falsos positivos de aproximadamente 5%. O sistema também pode diferenciar toques leves de toques mais intensos com 98% de precisão.

Essa sensibilidade ao tipo e força do toque permite que o EgoTouch funcione de forma semelhante a uma tela de toque, identificando comandos como pressionar, arrastar e levantar o dedo. Em smartphones, esses movimentos são essenciais para gestos como rolar uma página ou ampliar uma imagem. No caso do EgoTouch, a câmera distingue as sutis variações entre tipos de toque e a intensidade, possibilitando funções como o “clique direito” diretamente na pele.

A tecnologia foi testada em várias partes da mão e antebraço, com desempenho consistente em diferentes tons de pele e áreas com densidade variada de pelos, embora com menor eficiência em regiões ósseas, como os nós dos dedos, onde a deformação da pele é mínima. Mollyn também está estudando o uso de câmeras de visão noturna para que o EgoTouch funcione em ambientes com pouca luz e planeja expandir essa tecnologia para superfícies além da pele, oferecendo, pela primeira vez, uma interface intuitiva e prática apenas com o uso de uma câmera padrão dos headsets.