Por Kristin Houser

Publicado no Futurism

Inteligência geral

I.A.s já estão bastante eficazes em completar tarefas específicas, mas ainda falta muito para obterem inteligência geral, o tipo de capacidade intelectual generalizada que permitiria à I.A. navegar o mundo da mesma maneira que seres humanos e até algumas espécies de animais fazem.

Um dos elementos chave da inteligência geral é o raciocínio abstrato – a capacidade de pensar além do “aqui e agora” para perceber padrões mais obscuros e relações que emergem no pensamento complexo. Na quarta-feira passada, pesquisadores da DeepMind – uma subsidiária da Google focada em Inteligência Artificial – publicaram um artigo detalhando as suas diversas tentativas de medir a capacidade de raciocínio abstrato de uma I.A., e para fazer isso, eles observaram os mesmos testes que usamos para medir a nossa própria.

Q.I. humano

Em humanos, nós medimos o raciocínio abstrato usando testes visuais diretos de Q.I. Um teste popular, conhecido como Raven’s Progressive Matrices (“As Matrizes Progressivas de Raven”, em tradução literal) contém diversas colunas de imagens com a última coluna faltando uma imagem. Fica a cargo do participante escolher qual imagem deveria vir a seguir baseado nos padrões das colunas completadas.

O teste não diz de forma direta ao participante o que procurar nas imagens – talvez a progressão tenha a ver com o número de objetos dentro de cada imagem, suas cores, ou seu posicionamento. Cabe à ele descobrir isso por conta própria usando suas habilidades de raciocínio abstrato.

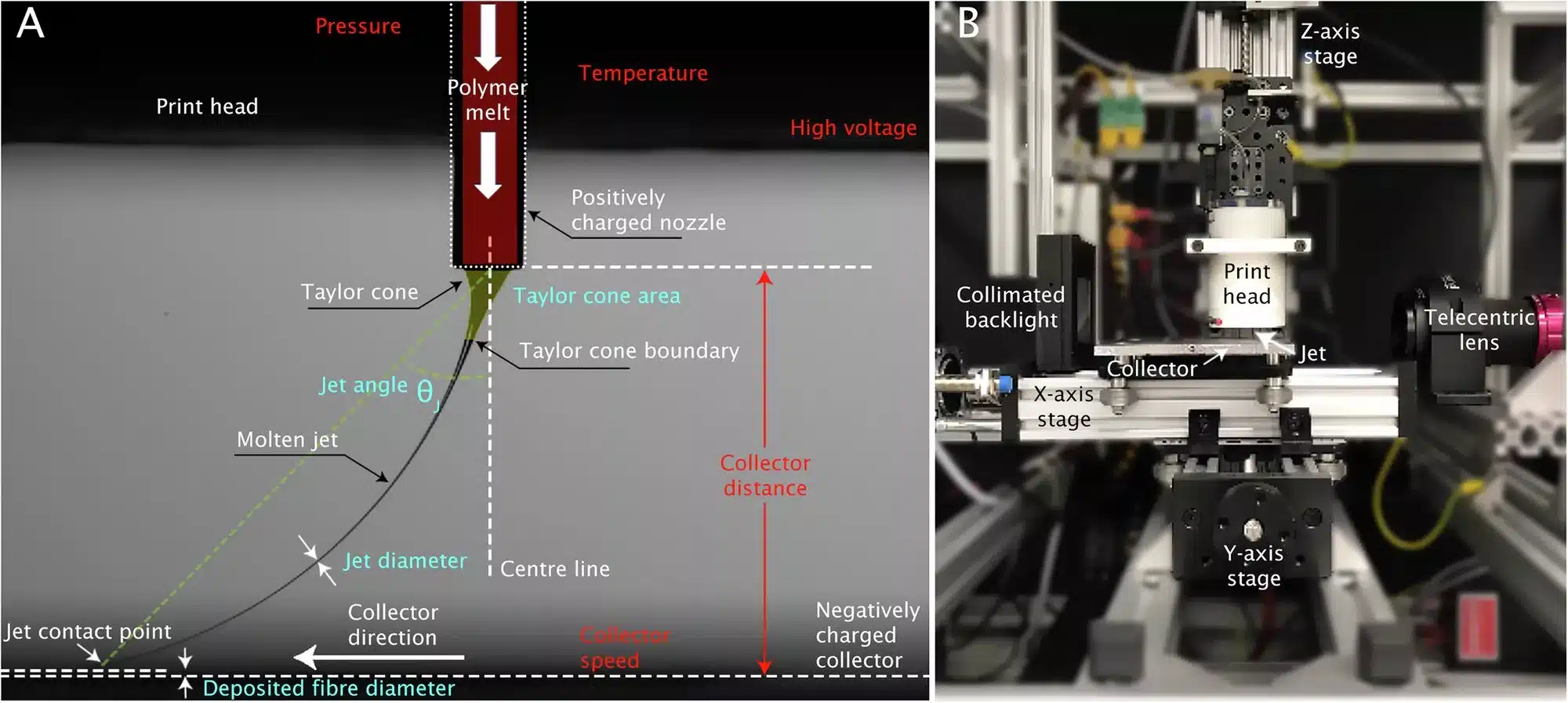

Para aplicar esse teste em I.A.s, os pesquisadores da DeepMind criaram um programa capaz de gerar matrizes únicas de problemas. Então, eles treinaram várias I.A.s para resolver esses problemas de matrizes.

Finalmente, eles testaram os sistemas. Em alguns casos, eles usaram testes com os mesmos fatores de abstração dos treinos – ou seja, treinando e testando a I.A. em problemas que exigiam que ela levasse em consideração o número de formas em cada imagem. Em outros casos, eles usaram no teste problemas incorporando fatores de abstração diferentes dos usados no treinamento. Por exemplo, treinando as I.A.s em problemas que as forçavam a levar em consideração o número de formas em cada imagem, mas então testando-os em problemas que requeriam que elas considerassem a posição dessas imagens para encontrar a resposta correta.

Mais sorte na próxima

Os resultados não foram muito bons. Quando os problemas de teste e de treino eram os mesmos, os sistemas se saíram OK, respondendo corretamente 75% das vezes. Porém, as I.A.s se saíram muito mal quando o conjunto de problemas de teste era diferente do conjunto de treino, mesmo quando a variância era mínima (por exemplo, treinando em matrizes que continham objetos de cor escura, e testando em matrizes com objetos de cor clara).

Por fim, os testes de QI para I.A.s da equipe mostram que mesmo algumas das I.A.s mais avançadas da atualidade não conseguem resolver problemas que nós não as tenhamos treinado para solucionar. Isso significa que nós provavelmente estamos muito longe ainda de uma I.A. geral. Mas, pelo menos, agora temos uma maneira simples de monitorar o seu progresso.