Pesquisadores da equipe de inteligência artificial da DeepMind, do Google, descobriram que certos modelos de linguagem amplos (LLMs) podem atuar como mediadores eficazes entre grupos com diferentes pontos de vista sobre um tema. O estudo, publicado na revista Science, propõe que essas ferramentas de IA podem ajudar a diminuir tensões em discussões polarizadas, criando oportunidades para um diálogo mais construtivo.

Nas últimas décadas, o aumento da polarização política tem sido uma constante em muitos países, com divisões marcadas entre visões liberais e conservadoras. A internet amplificou essas diferenças, permitindo a disseminação de opiniões extremas e alimentando sentimentos de frustração e conflito. Até agora, nenhuma solução efetiva foi desenvolvida para amenizar essas tensões. A equipe da DeepMind sugere que ferramentas de IA, como LLMs, podem ocupar esse espaço, funcionando como mediadores neutros e facilitadores de consenso.

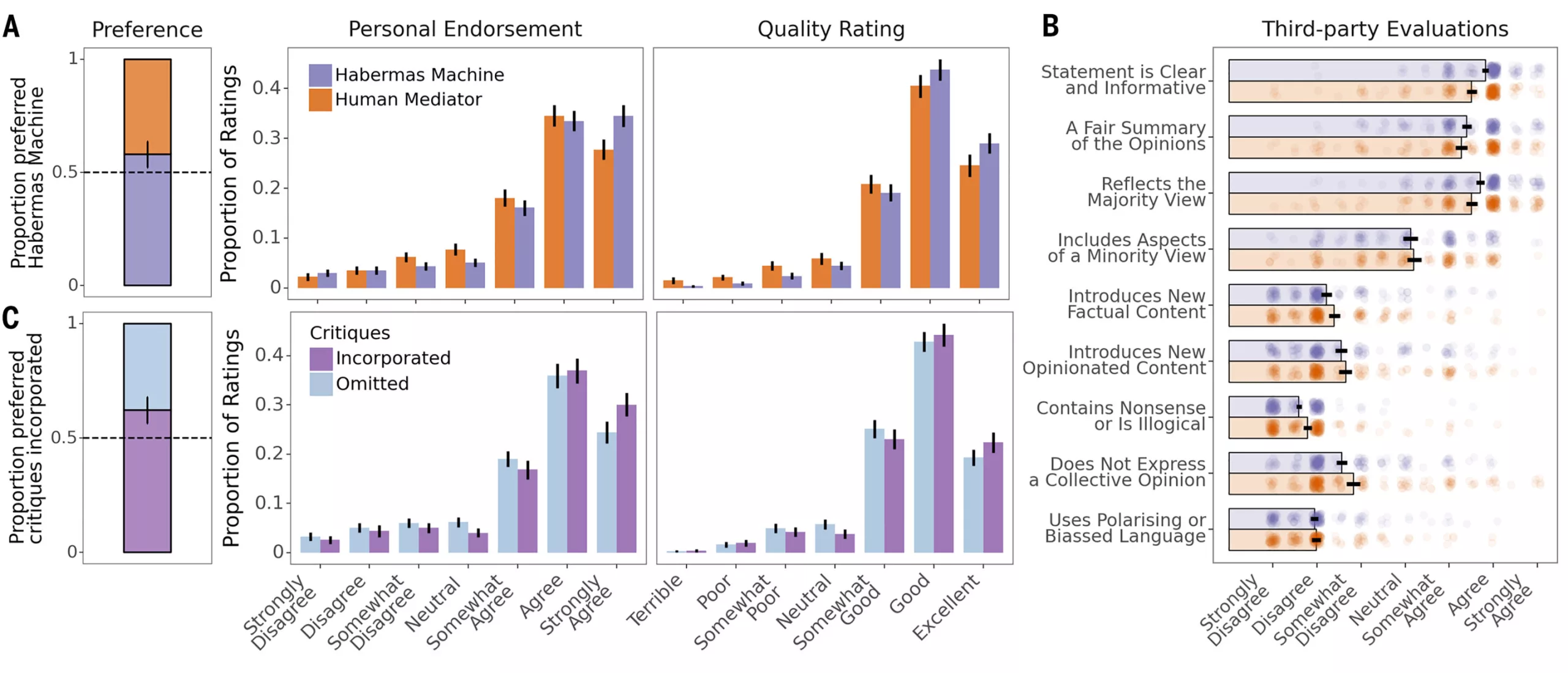

Para testar essa hipótese, os pesquisadores criaram um modelo de IA chamado Máquina de Habermas (‘Habermas Machine’ ou HM), especificamente treinado para mediar debates. O treinamento enfatizou a habilidade de identificar áreas de concordância entre grupos opostos, sem tentar alterar as opiniões individuais. A ideia era focar na construção de pontos comuns que poderiam servir como base para um diálogo mais produtivo.

Os experimentos foram conduzidos usando uma plataforma de crowdsourcing. Voluntários interagiram com o HM, que analisou suas perspectivas sobre tópicos políticos. Com base nessas interações, o HM gerou um documento que destacava as áreas de consenso entre os participantes. Após receber críticas dos voluntários, o HM revisava o documento, incorporando as sugestões para aprimorar a clareza e relevância das declarações.

Na fase final do estudo, os voluntários foram divididos em pequenos grupos e se revezaram como mediadores humanos, elaborando declarações que foram comparadas com aquelas criadas pelo HM. O objetivo era avaliar a qualidade das declarações e o impacto no entendimento entre os grupos. A máquina demonstrou um desempenho impressionante, superando os humanos em 56% das avaliações.

Os resultados mostraram que as declarações geradas pelo HM não apenas foram consideradas de qualidade superior, mas também contribuíram para reduzir a polarização entre os participantes. Após analisarem o material produzido pela IA, os grupos demonstraram estar menos divididos em suas opiniões, indicando que ferramentas como os LLMs podem ser úteis para promover debates mais equilibrados e construtivos.