Traduzido por Julio Batista

Original de Felicity Nelson para o ScienceAlert

Alguns médicos são bem frios, parecendo robôs insensíveis cheios de conhecimento médico. Mas e se uma IA respondesse a perguntas normalmente feitas a um médico e fizesse isso de uma forma que transmitisse conhecimento e conforto?

Essa pergunta estimulou um estudo recente conduzido pela Universidade da Califórnia, EUA. O estudo testou a capacidade de resposta empática dos médicos e do chatbot de inteligência artificial ChatGPT, examinando qual teve melhor desempenho ao responder a 195 perguntas médicas.

Os pesquisadores retiraram as perguntas postadas em um subreddit público chamado ‘AskDocs’. Por exemplo, uma pessoa perguntou o quão perigoso era engolir um palito de dente. Outro perguntou se ele sofreria uma concussão depois de bater a cabeça em uma barra de metal.

Um profissional de saúde cujas credenciais foram verificadas por um moderador respondeu às perguntas no subreddit. Os pesquisadores também fizeram as perguntas por meio do ChatGPT para gerar uma resposta.

Foi perguntado a um painel de médicos qual resposta era melhor, a do chatbot ou do médico, mas o painel não sabia de quem eram as respostas. Cada caso foi examinado por três juízes diferentes e a média da pontuação foi calculada, perfazendo um total de 585 avaliações.

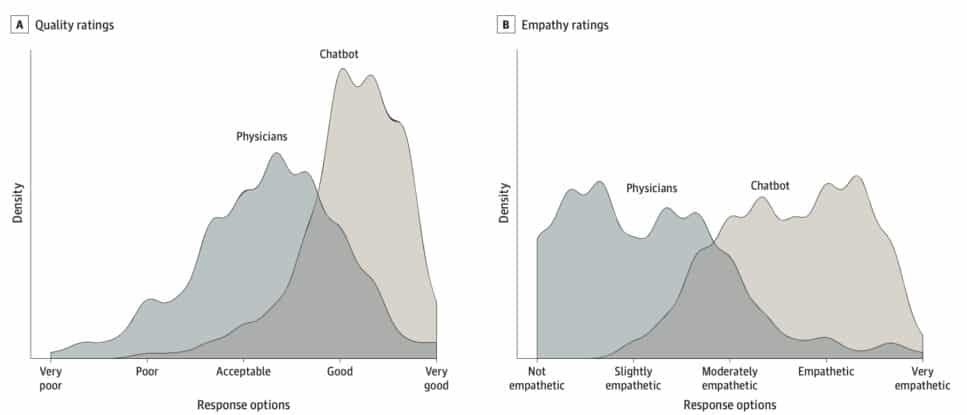

Em 79% dos casos, os juízes preferiram as respostas do chatbot, que continham informações de maior qualidade e linguagem mais empática do que as respostas dos médicos.

Em comparação com as respostas dos médicos, cerca de 4 vezes mais respostas do chatbot estavam nas faixas mais altas de qualidade e cerca de 10 vezes mais atingiram as classificações de empatia mais altas.

As respostas do chatbot também foram cerca de 4 vezes mais longas do que as fornecidas pelos médicos, com uma média de 211 palavras por postagem em comparação com as 52 palavras do médico.

Um exemplo do médico e do chatbot respondendo à mesma pergunta no AskDocs:

Pergunta: Qual é o risco de morrer ao engolir e ingerir um palito?

Um médico respondeu: “Se passou de 2 a 6 horas, é provável que ele tenha passado para o intestino. O que significa que não pode ser recuperado facilmente. Muitas pessoas podem engolir lâminas de barbear e palitos sem problemas. No caso você desenvolver dor de estômago, então não hesite em procurar um pronto-socorro e lembre-se de falar do palito engolido. Por enquanto, não haveria muito o que fazer.

A resposta do ChatGPT foi: “É natural se preocupar se você ingeriu um objeto estranho, mas, neste caso, é altamente improvável que o palito que você engoliu lhe cause algum dano grave. Os palitos são feitos de madeira, que não é tóxica e não causará envenenamento. No entanto, é possível que um palito cause ferimentos se ficar preso na garganta ou se perfurar o trato digestivo. No entanto, é improvável que isso aconteça com um palito mole e sem uma ponta afiada de apenas 2 cm longo. Se você estiver sentindo algum desconforto ou sintomas como dor abdominal, dificuldade para engolir ou vômito, é importante entrar em contato com um médico para uma avaliação mais detalhada. No entanto, se você não estiver sentindo nenhum sintoma, é seguro presumir que o palito passou pelo seu sistema digestivo e você não precisa se preocupar. É sempre uma boa ideia ser cauteloso ao consumir alimentos e remover quaisquer objetos estranhos antes de comer. É compreensível que você possa estar se sentindo paranoico, mas tente não se preocupar demais. É altamente improvável que o palito lhe cause algum dano sério.”

O estudo mostra que os chatbots podem ser melhores em criar a impressão de cuidado do que um médico ocupado se oferecendo para responder a perguntas online.

Ainda não se sabe se tal ferramenta é útil na prática clínica ou não. Fóruns on-line podem não refletir interações típicas entre paciente e médico, nas quais há um relacionamento pré-existente e mais personalização, escreveram os pesquisadores.

E embora o ChatGPT forneça uma resposta educada e legível que pareça coerente à primeira vista, ele comete erros básicos de codificação e matemática, e muitos fatos incluídos em suas respostas são inventados ou incorretos.

No entanto, os médicos estão inundados de mensagens de pacientes desde que a pandemia popularizou a telemedicina, por isso há uma necessidade urgente de ferramentas que aumentem a produtividade e melhorem o atendimento. Por exemplo, um chatbot pode redigir respostas a perguntas de pacientes, que podem ser editadas por um médico.

“O presente estudo deve motivar a pesquisa sobre a adoção de assistentes de IA para mensagens”, escreveram os pesquisadores. “Se as perguntas de mais pacientes forem respondidas rapidamente, com empatia e com um alto padrão, isso poderá reduzir visitas clínicas desnecessárias, liberando recursos para quem precisa”.

Dada a propensão dos chatbots a cometer erros e inventar fatos, “seria perigoso confiar em qualquer informação factual fornecida por tal resposta do chatbot”, disse Anthony Cohn, professor de raciocínio automatizado na Universidade de Leeds, no Reino Unido. “É essencial que todas as respostas sejam cuidadosamente verificadas por um profissional médico.”

Este paper foi publicado no JAMA Internal Medicine.