Pesquisadores da Universidade Johns Hopkins desenvolveram uma ferramenta capaz de detectar textos gerados por Inteligência Artificial (IA) e identificar qual modelo de linguagem os produziu. A descoberta, apresentada em uma conferência internacional de IA, destaca que tanto seres humanos quanto modelos de IA possuem estilos de escrita únicos, com características específicas que podem ser usadas para identificar a autoria. Isso abre novas possibilidades para combater plágios e desinformação online.

A ferramenta foi projetada inicialmente para identificar estilos de escrita humanos em casos de desinformação, mas demonstrou grande eficiência ao distinguir textos gerados por diferentes modelos de linguagem, como ChatGPT, Gemini e LLaMA. Cada modelo possui “impressões digitais linguísticas” distintas, permitindo uma identificação confiável, algo que surpreendeu os pesquisadores. O trabalho, segundo Nicholas Andrews, principal autor e cientista do Centro de Excelência em Tecnologia da Linguagem Humana da Johns Hopkins, é pioneiro na demonstração de que textos de IA possuem características semelhantes às de textos humanos.

Com a popularização de modelos como o ChatGPT, a criação de textos falsos se tornou acessível a qualquer pessoa. Embora muitos desses textos sejam inofensivos, há preocupações relacionadas ao uso indevido em plágios, spam e campanhas de desinformação. A ferramenta desenvolvida pelos pesquisadores promete ajudar a enfrentar esses desafios, além de auxiliar no controle do uso de sistemas de IA, identificando quais são mais propensos a abusos.

A equipe também descobriu que sua tecnologia, inicialmente não planejada para lidar com textos de IA, é mais precisa do que outros sistemas disponíveis. Diferentemente de detectores como o GPTZero, o modelo treinado pelos pesquisadores utiliza redes neurais para identificar padrões linguísticos, dispensando a análise manual de características como pontuação ou uso de voz ativa e passiva. Essa abordagem automatizada foi essencial para alcançar resultados superiores em um cenário de rápida evolução da IA.

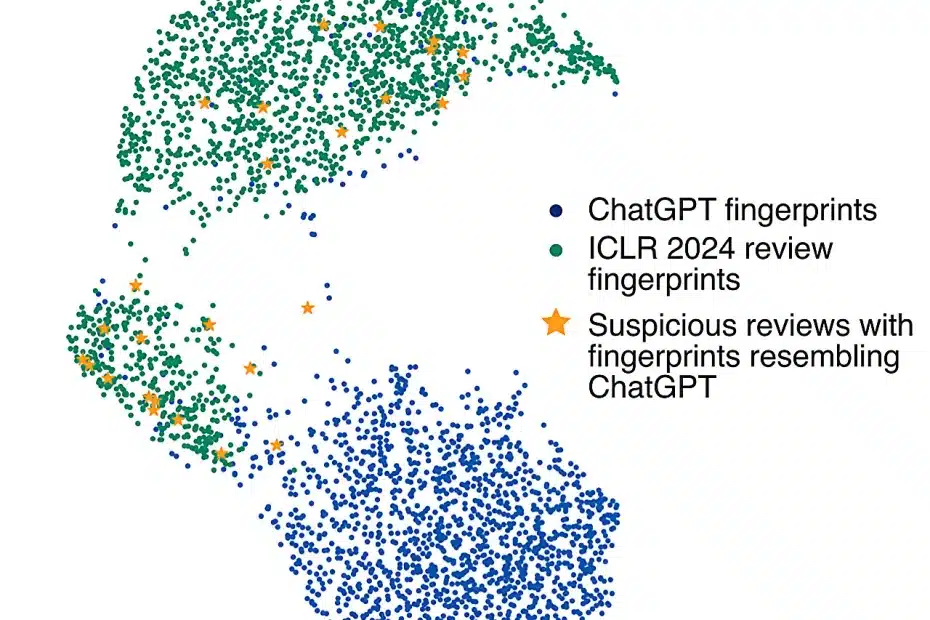

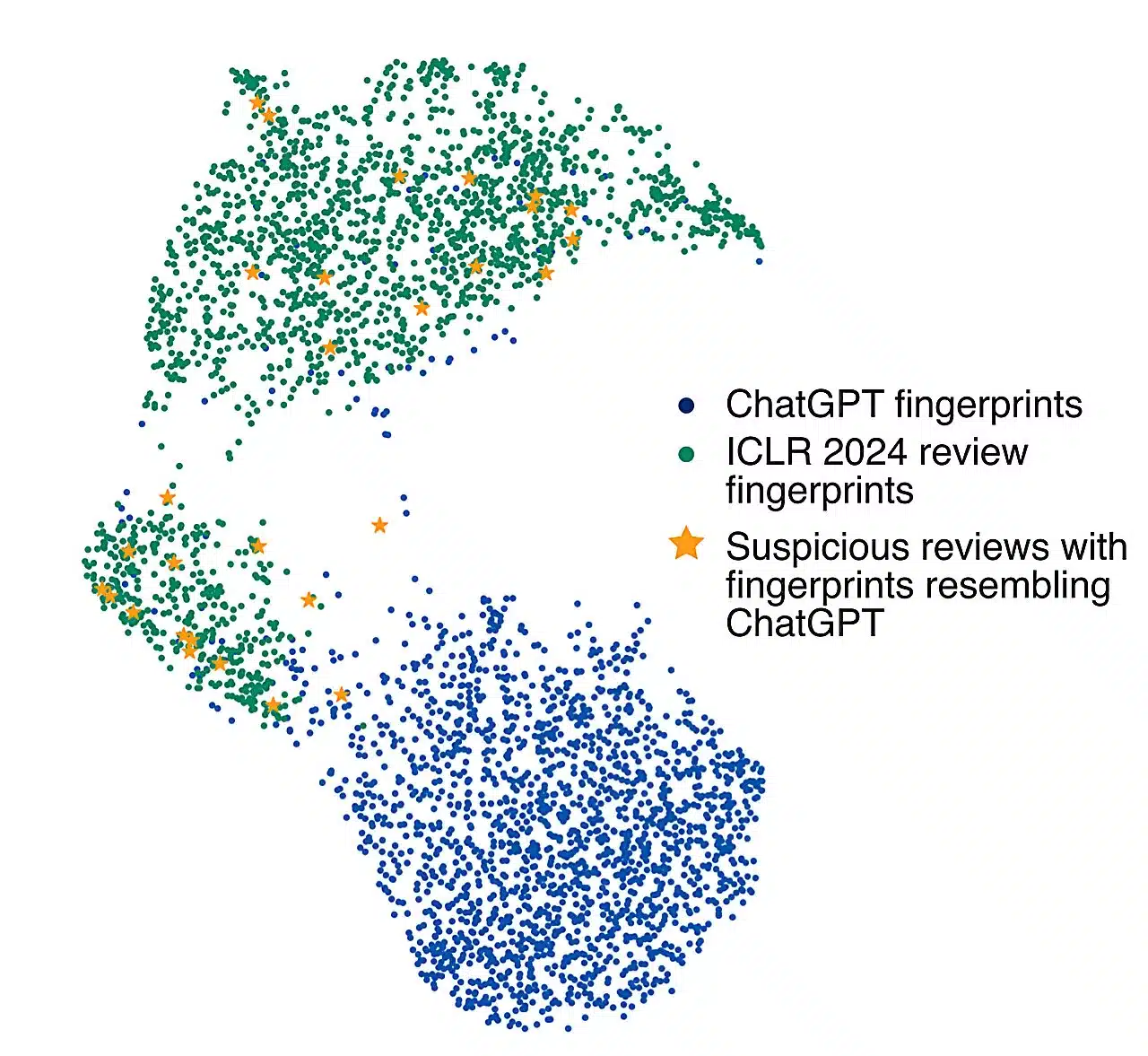

Os pesquisadores realizaram testes demonstrativos durante a conferência em que apresentaram o trabalho. Um deles analisou avaliações de artigos submetidos ao evento e revelou que cerca de 10% das análises provavelmente haviam sido geradas por IA, principalmente usando o ChatGPT. Esses resultados sublinham a relevância da ferramenta para identificar usos não declarados de modelos de linguagem em contextos acadêmicos e profissionais.

O estudo contou com contribuições de outros pesquisadores da Universidade Johns Hopkins, do Laboratório Nacional Lawrence Livermore e do Departamento de Defesa dos Estados Unidos. A expectativa é que a ferramenta continue a ser aprimorada e desempenhe um papel significativo na regulação ética e técnica da IA.