Por Monya Baker

Publicado na Nature

Não confie em tudo que você lê na literatura de psicologia. Na verdade, dois terços deveria ser posto em dúvida.

No maior projeto do gênero, Brian Nosek, um psicólogo social e chefe da Center for Open Science em Charlottesville, Virginia, e 269 coautores repetiram o trabalho reportado em 98 papers originais de três periódicos de psicologia, para ver se eles viriam independentemente com os mesmos resultados.

Os estudos usados variaram em expressar inseguranças perpetuadas sobre as diferenças na forma como crianças e adultos respondem aos estímulos do medo, de maneira eficaz como ensinar aritmética.

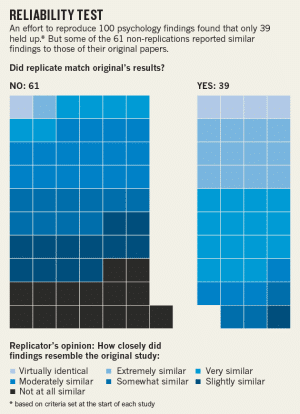

De acordo com as avaliações qualitativas dos replicadores, como publicado anteriormente pela Nature, apenas 39 das 100 tentativas de replicação foram bem sucedidas. (Havia 100 tentativas de replicação concluídas em 98 papers, como em dois casos, os esforços de replicação foram duplicados por equipes separadas.) Mas se uma tentativa de replicação é considerada bem sucedida não é tão simples. Hoje, na revista Science, a equipe relatou múltiplas medidas diferentes que foram utilizadas para responder a esta pergunta.

O 39% da figura deriva de avaliações subjetivas da equipe de sucesso ou fracasso (veja o gráfico, “Teste de Confiabilidade”). Outro método foi avaliado para saber se um efeito estatisticamente significativo poderia ser encontrado, e produziu um resultado ainda mais sombrio. Considerando que 97% dos estudos originais encontraram um efeito significativo, apenas 36% dos estudos replicados encontrou resultados significativos. A equipe também descobriu que a dimensão média dos efeitos encontrados nos estudos replicados era apenas metade do que tinha sido relatado nos estudos originais.

Não há nenhuma maneira de saber se qualquer paper individual é verdadeiro ou falso a partir deste trabalho, diz Nosek. O original ou o trabalho de replicação pode ser falho, ou diferenças cruciais entre os dois podem ser desvalorizadas. No geral, no entanto, o projeto aponta que a publicação generalizada do trabalho não resiste a um exame minucioso.

Embora Nosek seja rápido para dizer que a maioria dos recursos devem ser aplicados para novas pesquisas, ele sugere que um mero 3% do financiamento científico seja dedicado à replicação, uma vez que isso poderia fazer uma grande diferença. A quantidade atual, diz ele, é quase zero.

Falha de Replicação

O trabalho é parte do Projeto Reprodutibilidade, lançado em 2011 em meio a relatórios importantes de fraude e análise estatística defeituosa que levaram a uma crise de identidade na psicologia.

John Ioannidis, um epidemiologista da Universidade de Stanford, na Califórnia, diz que a verdadeira taxa de replicação-falha pode ser superior a 80%, ainda maior do que o estudo de Nosek sugere. Isso ocorre porque o Projeto de Reprodutibilidade direciona-se para periódicos altamente respeitados, os cientistas originais trabalham em estreita colaboração com os replicadores, e as equipes de replicação geralmente optam por papers que empregam métodos relativamente simples – todas as coisas que deveriam ter deixado mais fácil a replicação.

Mas, acrescenta, “Podemos realmente usá-lo para melhorar a situação, ao invés de apenas lamentar a situação. O simples fato de que essa colaboração aconteceu em tão grande escala sugere que os cientistas estão dispostos a se mover para uma direção melhor.”

O trabalho publicado na Science é diferente dos estudos anteriores sobre a replicação porque a equipe realmente replicou um grande leque de experiências, diz Andrew Gelman, um estatístico da Universidade de Columbia em Nova York. No passado, alguns pesquisadores rejeitaram as indicações de problemas generalizados porque envolviam pequenos esforços de replicação ou foram baseados em simulações estatísticas.

Mas eles terão mais dificuldade descartando o estudo mais recente, diz Gelman. “Isto é evidência empírica, não é um argumento teórico. O valor deste projeto é esperar que as pessoas sejam menos confiantes sobre suas reivindicações.”

Viés de Publicação

O ponto, diz Nosek, não é para criticar os trabalhos individuais, mas para avaliar quanto o viés impulsiona a publicação em psicologia. Por exemplo, encontrar um resultado significativo por pura sorte ou tentar vários métodos analíticos até que algo apareça.

Nosek acredita que outros campos científicos são susceptíveis a ter muito em comum com a psicologia. Uma análise revelou que apenas 6 de 53 papers importantes em biologia do câncer poderiam ser reproduzíveis e um projeto de reprodutibilidade relacionado em biologia do câncer está atualmente em curso. Os incentivos para encontrar resultados dignos de publicações importantes são muito fortes em todos os campos, e podem estimular as pessoas a perder a objetividade. “Se isso ocorrer em larga escala, então a literatura publicada pode ser mais bonita do que a realidade”, diz Nosek.

Os resultados publicados hoje devem desencadear um debate mais amplo sobre a prática científica ideal e a publicação, diz Betsy Levy Paluck, uma psicóloga social da Universidade de Princeton, em Nova Jersey. “Não sabemos o equilíbrio entre inovação e replicação.”

O fato de que o estudo foi publicado em um periódico de prestígio vai incentivar ainda mais a bolsa de estudos, ela diz, e mostra que agora “a replicação está sendo promovida como uma responsável e interessante linha de investigação”.