Com o avanço da inteligência artificial em diversas esferas da vida, cresce a preocupação com os riscos que essa tecnologia pode representar. Especialistas alertam que alguns desses riscos são urgentes, enquanto outros podem demorar meses ou até anos para se manifestar. Um estudo publicado na revista Philosophical Transactions of the Royal Society A sugere que ainda falta uma abordagem coesa para avaliar esses riscos. O artigo defende uma perspectiva baseada em sistemas complexos para compreender e mitigar os perigos da IA, considerando especialmente as incertezas a longo prazo e as interações complexas entre a IA e a sociedade.

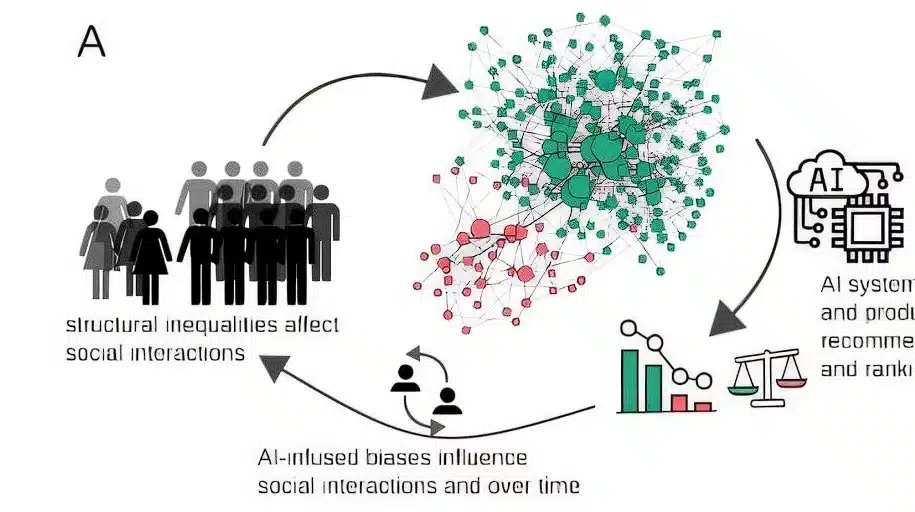

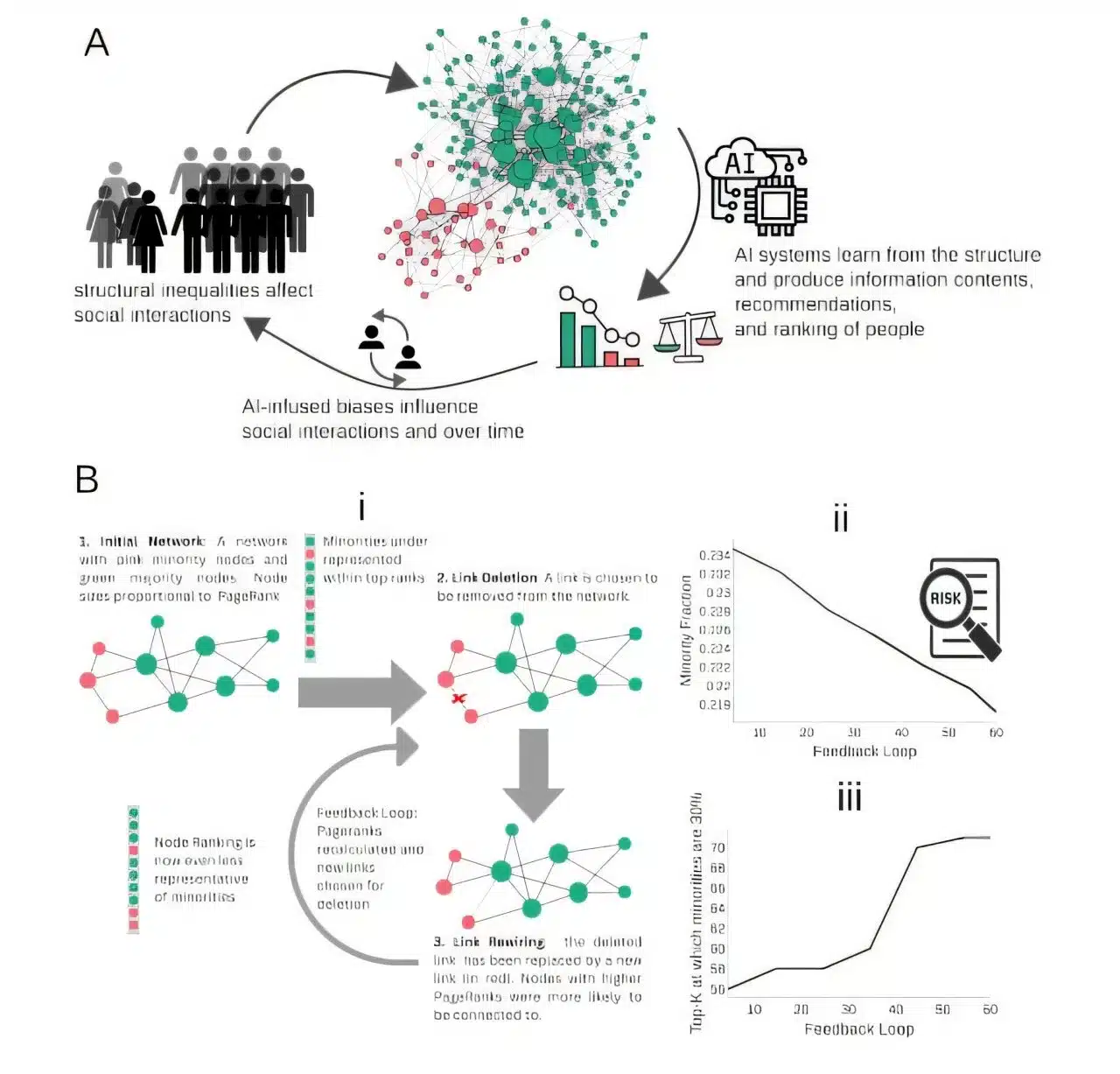

Os pesquisadores apontam que compreender os riscos da IA envolve reconhecer a relação intrincada entre tecnologia e sociedade, destacando que a IA não deve ser vista isoladamente, mas como parte de um sistema que afeta e é afetado pelas escolhas e comportamentos humanos. Fariba Karimi, coautora do estudo e professora de Ciência de Dados Sociais, ressalta que a avaliação de riscos da IA deve incluir tanto as tecnologias em si quanto o contexto social em que são aplicadas. A análise deve ir além das questões técnicas para promover um entendimento que permita explorar as possibilidades da IA e debater suas implicações políticas e econômicas.

Os autores também destacam que os métodos atuais de avaliação de riscos geralmente focam em problemas imediatos, como preconceitos e questões de segurança, negligenciando riscos sistêmicos mais amplos e a longo prazo que podem surgir com a ampla adoção da IA em diferentes contextos. No estudo, os cientistas tentaram equilibrar as perspectivas de curto prazo com uma visão de longo prazo, que explora como essas tecnologias influenciam a sociedade de forma mais ampla e complexa. Esse entendimento é essencial para prever e responder adequadamente aos impactos de longo prazo da IA.

Um exemplo citado para ilustrar os potenciais riscos de tecnologias de IA é o uso de um algoritmo preditivo durante a pandemia de COVID-19 no Reino Unido, empregado para avaliação de exames escolares. A ideia era que o algoritmo fosse mais objetivo e justo, mas sua aplicação expôs desigualdades significativas. Estudantes de comunidades desfavorecidas foram prejudicados, recebendo notas abaixo do esperado devido a um sistema que priorizava a análise estatística de desempenhos passados. Essa situação revela uma divergência entre as percepções de risco dos desenvolvedores do algoritmo, focados em evitar inflação de notas, e dos professores, preocupados com os efeitos a longo prazo nas oportunidades educacionais dos alunos.

Para os cientistas, esse caso exemplifica a importância de considerar a escala e o alcance das soluções algorítmicas, pois essas tecnologias são frequentemente aplicadas em contextos diferentes dos originalmente planejados. Esse deslocamento pode intensificar riscos a longo prazo, que não são simplesmente a soma dos riscos imediatos. Os autores sugerem que modelos computacionais e simulações podem ajudar a avaliar esses riscos dinâmicos, oferecendo uma visão prática que vai além dos métodos tradicionais de análise.

O estudo também enfatiza a importância de envolver tanto o público quanto especialistas de várias áreas no processo de avaliação de riscos da IA. Pequenos grupos heterogêneos de competência, compostos por pessoas com diferentes perspectivas, podem promover uma participação democrática e garantir que a análise dos riscos seja informada pelas necessidades daqueles mais impactados pelas tecnologias de IA. A promoção da resiliência social é vista como um componente essencial para aprimorar o debate e a tomada de decisões sobre IA, facilitando uma abordagem que inclua as necessidades e interesses dos cidadãos e permita que os afetados pela IA tenham um papel na criação de sistemas adaptados às suas realidades.