A Inteligência Artificial (IA) está fazendo valer sua presença de milhares de maneiras diferentes. Ajuda os cientistas a compreender vastas quantidades de dados; ajuda a detectar fraudes financeiras; dirige nossos carros; nos dá sugestões musicais; seus chatbots nos deixam loucos. E está apenas começando.

Leia também: IA usou armas nucleares ‘para ter paz no mundo’ em simulação de guerra tensa

Seremos capazes de compreender a rapidez com que a IA continuará a se desenvolver? E se a resposta for não, isso constitui o Grande Filtro?

O Paradoxo de Fermi é a discrepância entre a aparente alta probabilidade de existência de civilizações avançadas e a total falta de evidências de que elas existam. Muitas soluções foram propostas para explicar a existência da discrepância. Uma das ideias é o ‘Grande Filtro‘.

O Grande Filtro é um evento ou situação hipotética que impede que a vida inteligente se torne interplanetária e interestelar e até leva ao seu desaparecimento. Pense nas mudanças climáticas, na guerra nuclear, nos ataques de asteróides, nas explosões de supernovas, nas pragas ou em qualquer outra coisa da galeria de eventos cataclísmicos.

Ou que tal o rápido desenvolvimento da IA?

Um novo artigo na Acta Astronautica explora a ideia de que a Inteligência Artificial se torna Superinteligência Artificial (ASI) e que a ASI é o Grande Filtro. O título do artigo é “A Inteligência Artificial é o Grande Filtro que torna raras as civilizações técnicas avançadas no universo?” O autor é Michael Garrett, do Departamento de Física e Astronomia da Universidade de Manchester.

“Sem regulamentação prática, há todas as razões para acreditar que a IA poderá representar uma grande ameaça ao curso futuro não só da nossa civilização técnica, mas de todas as civilizações técnicas.”

Michael Garrett, Universidade de Manchester

Alguns pensam que o Grande Filtro impede que espécies tecnológicas como a nossa se tornem multiplanetárias. Isso é ruim porque uma espécie corre maior risco de extinção ou estagnação com apenas um lar. De acordo com Garrett, uma espécie está numa corrida contra o tempo sem um planeta reserva.

“É proposto que tal filtro surja antes que estas civilizações possam desenvolver uma existência estável e multiplanetária, sugerindo que a longevidade típica (L) de uma civilização técnica é inferior a 200 anos”, escreve Garrett.

Se for verdade, isso pode explicar por que não detectamos assinaturas tecnológicas ou outras evidências de ETIs (Inteligências Extraterrestres). O que isso nos diz sobre a nossa própria trajetória tecnológica? Se enfrentarmos uma restrição de 200 anos, e se for por causa da ASI, onde é que isso nos deixa?

Garrett sublinha a “…necessidade crítica de estabelecer rapidamente quadros regulamentares para o desenvolvimento da IA na Terra e o avanço de uma sociedade multiplanetária para mitigar tais ameaças existenciais.”

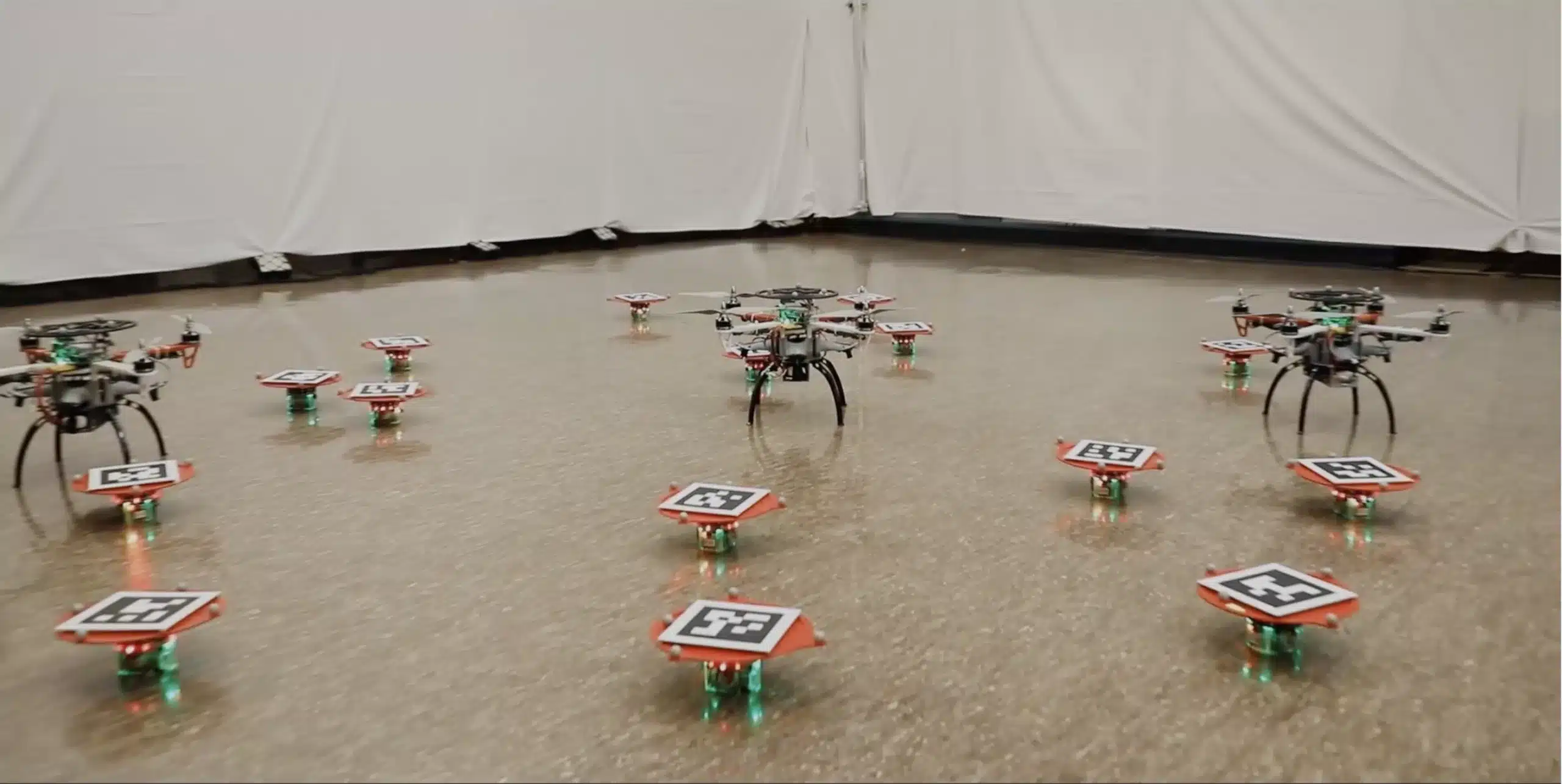

Muitos cientistas e outros pensadores dizem que estamos à beira de uma enorme transformação. A IA está apenas começando a transformar a forma como fazemos as coisas; grande parte da transformação está nos bastidores. A IA parece preparada para eliminar empregos para milhões de pessoas e, quando aliada à robótica, a transformação parece quase ilimitada. Essa é uma preocupação bastante óbvia.

Mas existem preocupações mais profundas e sistemáticas. Quem escreve os algoritmos? A IA discriminará de alguma forma? Quase certamente. Irão os algoritmos concorrentes minar sociedades democráticas poderosas? As sociedades abertas permanecerão abertas? A ASI começará a tomar decisões por nós e quem será responsável se isso acontecer?

Esta é uma árvore em expansão de questões ramificadas sem um término claro.

Stephen Hawking (RIP) alertou que a IA poderia acabar com a humanidade se ela começasse a evoluir de forma independente.

“Temo que a IA possa substituir completamente os humanos. Se as pessoas criam vírus de computador, alguém projetará uma IA que se aperfeiçoe e se reproduza. Esta será uma nova forma de vida que superará os humanos”, disse ele à revista Wired em 2017. Assim que a IA puder superar o desempenho humano, torna-se ASI.

Hawking pode ser uma das vozes mais reconhecidas a emitir alertas sobre IA, mas está longe de ser o único. A mídia está repleta de discussões e avisos, além de artigos sobre o trabalho que a IA faz por nós. Os avisos mais alarmantes dizem que a ASI pode se tornar desonesta. Algumas pessoas consideram isso ficção científica, mas Garrett não.

“As preocupações sobre a superinteligência artificial (ASI) eventualmente se tornarem desonestas são consideradas uma questão importante – combater essa possibilidade nos próximos anos é uma busca crescente de pesquisa para os líderes na área”, escreve Garrett.

Se a IA não proporcionasse benefícios, a questão seria muito mais fácil. Mas proporciona todos os tipos de benefícios, desde melhores imagens e diagnósticos médicos até sistemas de transporte mais seguros. O truque para os governos é permitir que os benefícios floresçam e, ao mesmo tempo, limitar os danos.

“Este é especialmente o caso em áreas como a segurança e a defesa nacionais, onde o desenvolvimento responsável e ético deve ser primordial”, escreve Garrett.

O problema é que nós e os nossos governos não estamos preparados. Nunca existiu nada parecido com a IA e, por mais que tentemos conceituá-la e compreender sua trajetória, ficamos em dúvida.

E se estivermos nesta posição, o mesmo acontecerá com qualquer outra espécie biológica que desenvolva IA. O advento da IA e depois da ASI poderia ser universal, tornando-a candidata ao Grande Filtro.

Este é o risco que a ASI representa em termos concretos: poderia já não precisar da vida biológica que a criou.

“Ao atingir uma singularidade tecnológica, os sistemas ASI ultrapassarão rapidamente a inteligência biológica e evoluirão a um ritmo que ultrapassa completamente os mecanismos tradicionais de supervisão, levando a consequências imprevistas e não intencionais que provavelmente não estarão alinhadas com os interesses biológicos ou com a ética”, explica Garrett.

Como a ASI poderia se livrar da incômoda vida biológica que a cerca? Poderia criar um vírus mortal, poderia inibir a produção e distribuição de alimentos agrícolas, poderia forçar o derretimento de uma central nuclear e poderia iniciar guerras.

Nós realmente não sabemos porque é tudo um território desconhecido. Centenas de anos atrás, os cartógrafos desenhavam monstros nas regiões inexploradas do mundo, e é isso que estamos fazendo agora.

Se tudo isso parece desesperador e inevitável, Garrett diz que não é.

Sua análise até agora é baseada na ASI e nos humanos ocupando o mesmo espaço. Mas se conseguirmos atingir o estatuto multiplanetário, a perspectiva muda.

“Por exemplo, uma espécie biológica multiplanetária poderia tirar vantagem de experiências independentes em diferentes planetas, diversificando as suas estratégias de sobrevivência e possivelmente evitando a falha pontual que uma civilização ligada ao planeta enfrenta”, escreve Garrett.

Se conseguirmos distribuir o risco por vários planetas em torno de múltiplas estrelas, poderemos proteger-nos contra os piores resultados possíveis da ASI.

“Este modelo distribuído de existência aumenta a resiliência de uma civilização biológica às catástrofes induzidas pela IA, criando redundância”, escreve ele.

Se um dos planetas ou postos avançados que os futuros humanos ocuparão não conseguir sobreviver à singularidade tecnológica da ASI, outros poderão sobreviver. E eles aprenderiam com isso.

O status multiplanetário pode até fazer mais do que apenas sobreviver à ASI. Isso poderia nos ajudar a dominá-lo. Garrett imagina situações em que podemos experimentar mais detalhadamente a IA, mantendo-a contida. Imagine a IA num asteroide isolado ou num planeta anão, cumprindo as nossas ordens sem acesso aos recursos necessários para escapar da sua prisão.

“Isso permite ambientes isolados onde os efeitos da IA avançada podem ser estudados sem o risco imediato de aniquilação global”, escreve Garrett.

Mas aqui está o enigma. O desenvolvimento da IA prossegue a um ritmo acelerado, enquanto as nossas tentativas de nos tornarmos multiplanetários não o fazem.

“A disparidade entre o rápido avanço da IA e o progresso mais lento da tecnologia espacial é gritante”, escreve Garrett.

A diferença é que a IA é computacional e informativa, mas as viagens espaciais contêm múltiplos obstáculos físicos que ainda não sabemos como superar. A nossa própria natureza biológica restringe as viagens espaciais, mas nenhum obstáculo desse tipo restringe a IA.

“Embora a IA possa, teoricamente, melhorar as suas próprias capacidades quase sem restrições físicas”, escreve Garrett, “as viagens espaciais devem enfrentar as limitações de energia, os limites da ciência dos materiais e as duras realidades do ambiente espacial”.

Por enquanto, a IA opera dentro das restrições que estabelecemos. Mas nem sempre é esse o caso. Não sabemos quando a IA poderá se tornar ASI ou mesmo se poderá. Mas não podemos ignorar a possibilidade. Isso leva a duas conclusões interligadas.

Se Garrett estiver correto, a humanidade deve trabalhar com mais diligência nas viagens espaciais. Pode parecer absurdo, mas as pessoas bem informadas sabem que é verdade: a Terra não será habitável para sempre. A humanidade perecerá aqui pelas nossas próprias mãos ou pelas mãos da natureza se não nos expandirmos para o espaço. A estimativa de 200 anos de Garrett apenas coloca um ponto de exclamação nisso. Uma ênfase renovada em chegar à Lua e a Marte oferece alguma esperança.

A segunda conclusão diz respeito à legislação e à governação da IA, uma tarefa difícil num mundo onde os psicopatas podem obter o controle de nações inteiras e estão empenhados em travar a guerra.

“Embora as partes interessadas da indústria, os decisores políticos, os especialistas individuais e os seus governos já avisem que a regulamentação é necessária, estabelecer um quadro regulamentar que possa ser globalmente aceitável será um desafio”, escreve Garrett.

Desafiador mal descreve isso. As disputas internas da humanidade tornam tudo ainda mais incontrolável. Além disso, não importa a rapidez com que desenvolvemos diretrizes, a ASI poderá mudar ainda mais rapidamente.

“Sem regulamentação prática, há todos os motivos para acreditar que a IA pode representar uma grande ameaça ao curso futuro não apenas da nossa civilização técnica, mas de todas as civilizações técnicas”, escreve Garrett.

Se o fizermos, poderá acabar por se resumir ao que pode parecer enfadonho e quotidiano: disputas sobre legislação.

“A persistência da vida inteligente e consciente no universo poderia depender da implementação oportuna e eficaz de tais medidas regulatórias internacionais e esforços tecnológicos”, escreve Garrett.

Este artigo foi publicado originalmente pela Universe Today. Leia o artigo original.

Adaptado de ScienceAlert