Traduzido por Julio Batista

Original de Kamal Nahas para a Science

Enquanto os neurocientistas têm dificuldades para desmistificar como o cérebro humano converte o que nossos olhos veem em imagens mentais, a inteligência artificial (IA) está avançando em imitar essa façanha. Um estudo recente, programado para ser apresentado em uma conferência sobre visão computacional, demonstra que a IA pode ler varreduras cerebrais e recriar versões amplamente realistas de imagens que uma pessoa viu. À medida que essa tecnologia se desenvolve, disseram os pesquisadores, ela pode ter inúmeras aplicações, desde explorar como várias espécies animais percebem o mundo até talvez um dia registrar sonhos humanos e auxiliar na comunicação de pessoas com paralisia.

Muitos laboratórios usaram IA para ler varreduras cerebrais e recriar imagens que um sujeito viu recentemente, como rostos humanos e fotos de paisagens. O novo estudo marca a primeira vez que um algoritmo de IA chamado Stable Diffusion, desenvolvido por um grupo alemão e lançado publicamente em 2022, foi usado para fazer isso. A Stable Diffusion é semelhante a outras IAs “generativas” de texto para imagem, como DALL-E 2 e Midjourney, que produzem novas imagens a partir de prompts de texto após serem treinadas em bilhões de imagens associadas a descrições de texto.

Para o novo estudo, um grupo no Japão adicionou treinamento adicional ao sistema Stable Diffusion padrão, vinculando descrições de texto adicionais sobre milhares de fotos a padrões cerebrais obtidos quando essas fotos foram observadas por participantes em estudos de varredura cerebral.

Ao contrário dos esforços anteriores usando algoritmos de IA para decifrar varreduras cerebrais, que precisavam ser treinadas em grandes conjuntos de dados, o Stable Diffusion conseguiu obter mais com menos treinamento para cada participante, incorporando legendas de fotos ao algoritmo. É uma nova abordagem que incorpora informações textuais e visuais para “decifrar o cérebro”, disse Ariel Goldstein, neurocientista cognitivo da Universidade de Princeton, EUA, que não participou do trabalho.

O algoritmo de IA faz uso de informações coletadas de diferentes regiões do cérebro envolvidas na percepção de imagens, como os lobos occipital e temporal, de acordo com Yu Takagi, neurocientista de sistemas da Universidade de Osaka que trabalhou no experimento. O sistema interpretou informações de exames cerebrais de ressonância magnética funcional (fMRI), que detectam alterações no fluxo sanguíneo para regiões ativas do cérebro. Quando as pessoas olham para uma foto, os lobos temporais registram predominantemente informações sobre o conteúdo da imagem (pessoas, objetos ou cenários), enquanto o lobo occipital registra predominantemente informações sobre esboços e perspectivas, como escala e posição dos conteúdos. Todas essas informações são registradas pelo fMRI, uma vez que captura picos na atividade cerebral, e esses padrões podem ser reconvertidos em uma imagem de imitação usando IA.

No novo estudo, os pesquisadores adicionaram treinamento adicional ao algoritmo Stable Diffusion usando um conjunto de dados online fornecido pela Universidade de Minnesota, EUA, que consistia em varreduras cerebrais de quatro participantes enquanto cada um visualizava um conjunto de 10.000 fotos. Uma parte dessas varreduras cerebrais dos mesmos quatro participantes não foi usada no treinamento, mas sim usadas para testar o sistema de IA posteriormente.

Cada imagem gerada por IA começa como ruído, reminiscente da estática da TV, e substitui o ruído por recursos distinguíveis, pois o algoritmo Stable Diffusion compara os padrões de atividade cerebral de uma pessoa ao visualizar uma foto com os padrões em seu conjunto de dados de treinamento. O sistema gera efetivamente uma imagem representando o conteúdo, esboço e perspectiva da foto que está sendo visualizada. Takagi disse que o novo sistema era mais eficiente que os anteriores, exigia menos ajustes e podia ser treinado com um conjunto de dados menor.

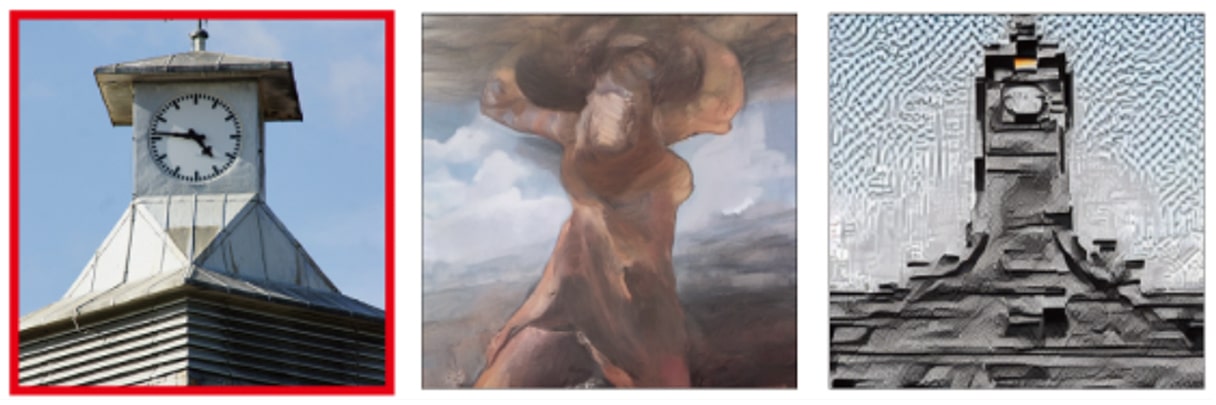

A atividade cerebral, predominantemente no lobo occipital, forneceu informações suficientes para recriar o esboço e a perspectiva das fotos visualizadas, descobriram os pesquisadores. Mas o algoritmo teve dificuldades para recapitular objetos, como uma torre de relógio, a partir da foto real e, em vez disso, criou figuras abstratas. Uma abordagem para lidar com esse problema seria usar conjuntos de dados de treinamento maiores que pudessem treinar o algoritmo para prever mais detalhes, mas o conjunto de dados de fMRI era muito limitado para isso, disse a equipe japonesa.

Em vez disso, os pesquisadores contornaram esse problema aproveitando as palavras-chave das legendas das imagens que acompanhavam as fotos no conjunto de dados de fMRI da Universidade de Minnesota. Se, por exemplo, uma das fotos de treinamento contivesse uma torre de relógio, o padrão de atividade cerebral da varredura seria associado a esse objeto. Isso significava que, se o mesmo padrão cerebral fosse exibido mais uma vez pelo participante do estudo durante o estágio de teste, o sistema alimentaria a palavra-chave do objeto no gerador de texto para imagem do Stable Diffusion e uma torre de relógio seria incorporada a imagem recriada, seguindo o esboço e perspectiva indicados pelo padrão cerebral, resultando em uma imitação convincente da foto real.

É importante ressaltar que o algoritmo de Stable Diffusion não recebe um prompt de texto diretamente dos dados do teste – ele só pode inferir que um objeto está presente se o padrão cerebral corresponder ao visto nos dados de treinamento. Isso limita os objetos que ele pode recriar aos presentes nas fotos usadas durante o treinamento.

Por fim, os pesquisadores testaram seu sistema em varreduras cerebrais adicionais dos mesmos participantes quando visualizaram um conjunto separado de fotos, incluindo um urso de pelúcia, avião, relógio e trem. Ao comparar os padrões cerebrais dessas imagens com os produzidos pelas fotos no conjunto de dados de treinamento, o sistema de IA foi capaz de produzir imitações convincentes das novas fotos (a equipe publicou uma pré-publicação de seu trabalho em dezembro de 2022).

“A precisão desse novo método é impressionante”, disse Iris Groen, neurocientista da Universidade de Amsterdã que não participou do trabalho.

No entanto, o sistema de IA foi testado apenas em varreduras cerebrais das mesmas quatro pessoas que forneceram as varreduras cerebrais de treinamento, e expandi-lo para outros indivíduos exigiria um novo treinamento do sistema em suas varreduras cerebrais. Portanto, pode demorar um pouco para que essa tecnologia se torne amplamente acessível. No entanto, Groen argumenta que “esses modelos de difusão têm uma capacidade sem precedentes de gerar imagens realistas” e podem criar novas oportunidades para a pesquisa em neurociência cognitiva.

Shinji Nishimoto, outro neurocientista de sistemas da Universidade de Osaka que trabalhou no estudo, espera que, com mais refinamentos, a tecnologia possa ser usada para interceptar pensamentos e sonhos, ou permitir que os cientistas entendam como outros animais percebem a realidade de maneira diferente.