Original por Symmetry Magazine

A próxima década (2020) pode ver uma rápida expansão nas pesquisas sobre energia escura.

Para começar, dois poderosos novos instrumentos vão escanear o céu noturno em busca de galáxias distantes. O instrumento espectroscópico de energia escura (DESI – Dark Energy Spectroscopic Instrument) vai medir a distância até uns 35 milhões de objetos cósmicos, e o Large Synoptic Survey Telescope, LSST, vai capturar vídeos de alta resolução de aproximadamente 40 bilhões de galáxias.

Ambos os projetos vão sondar como energia escura – o fenômeno que os cientistas suspeitam estar causando a expansão acelerada do universo – tem moldado a estrutura do universo com o decorrer do tempo.

Mas cientistas estão usando mais que telescópios para buscar por pistas da natureza da matéria escura. Cada vez mais, pesquisa de energia escura não está tomando lugar apenas no topo de montanhas em observatórios com vistas panorâmicas, mas também em salas frias e sussurrantes que abrigam super computadores do estado da arte.

“Quando nós analisamos as observações do universo, nos não sabemos qual é o modelo subjacente pois não sabemos a natureza da energia escura,” diz Katrin Hatmann, uma física no Argonne National Laboratory. “Mas com simulações em computadores, nós podemos modelar o que estamos colocando, e assim podemos observar os efeitos que teria nos dados observados.”

Crescendo um Universo

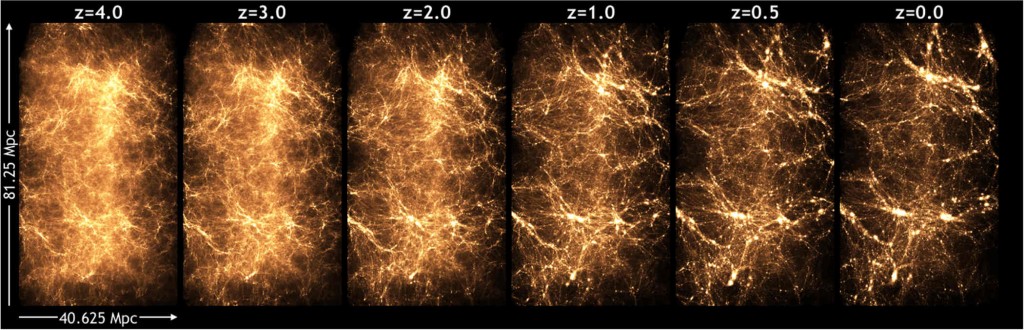

Heitmann e seus colegas em Argonne usam o seu código cosmológico, chamado HACC, para simular a estrutura e evolução do universo em super computadores. Os super computadores necessários para esses testes são constituídos de dezenas de milhares de processadores conectados e tipicamente computados a mais de um quadrilhão de cálculos por segundo.

O time de Argonne recentemente terminou uma simulação de alta resolução do universo em expansão mudando em 13 bilhões de anos, a maior parte de sua vida. Agora os dados dessa simulação está sendo usado para desenvolver ferramentas de processamento e análise do LSST, e pacotes de dados estão sendo liberados para a comunidade de pesquisadores para que cosmólogos sem acesso a super computadores possam fazer uso do resultado para um estudo mais amplo.

Risha Wechsler, uma cientistas no SLAC National Accelerator Laboraty e professora de Stanford, é porta-voz do experimento DESI. Wechsler está produzindo simulações que estão sendo usadas para interpretar as medidos do Dark Energy Survey em andamento, além de servirem para desenvolver ferramentas de análise para futuros experimentos como DESI e LSST.

“Por testar nossas predições atuais com os dados existentes do Dark Energy Survey, estamos aprendendo onde que o modelo precisa ser melhorado no futuro,” diz Wechsler. “Simulações são nossas principais ferramentas preditivas. Em simulações cosmológicas, nós começamos com um universo novo com pequenas flutuações, ou mudanças de densidades, e a gravitação permite que essas flutuações cresçam com o tempo. O crescimento da estrutura se torna mais e mais complicado tornando impossível calcular com papel e caneta. Nós precisamos de super computadores.”

Super computadores tem se tornado extremamente valiosos para estudar energia escuro porque – diferente de matéria escura, qual os cientistas talvez sejam capaz de produzir em aceleradores – energia escura pode apenas ser observada na escala galática.

“Com energia escura, podemos ver apenas seus efeitos entre galáxias,” diz Peter Nugent, da divisão de deputados para compromisso com ciência do Centro de Cosmologia Computacional no Lawrence Berkeley National Laboratory.

Tentativas e Barras de Erros

“Existem dois tipos de erros em cosmologia,” Diz Heitmann. “Erros estatísticos, significando que não coletamos dados suficientes, e erros sistemáticos, significando que existe algo nos dados que nós não entendemos. “

Modelagem computacional pode ajudar a reduzir ambos.

O DESI vai coletar aproximadamente 10 vezes mais dados que seu predecessor, o Baryon Oscillation Spectroscopic Survey, e o LSST vai gerar em torno de 3 laptops de dado cada noite. Mas mesmo essas quantidades enormes de dados não eliminam os erros estatísticos. Simulações podem apoiar evidências observadas por modelar condições similares para ver se os resultados parecem consistentes.

“Nós estamos basicamente criando um conjunto de dados como os dos dados observados, e então estamos fazendo isso de novo e de novo – produzindo de 10 à 100 vezes mais dados do que o conjunto dos dados observados,” diz Nugent.

Processar quantidades tão grande de dados requer análise sofisticadas. Simulações tornam isso possível.

Para programar as ferramentas que vão comparar dados simulados e observados, primeiro os pesquisadores tem que modelar o que o céu vai parecer através das lentes de um telescópio. Nesse caso da LSST, isso é feito antes mesmo que o telescópio seja construído.

Após popular o universo simulado com galáxias similares em brilho e distribuição à galáxias reais, cientistas modificam o resultado para considerar a óptica do telescópio, a atmosfera terrestre, e outros fatores limitante. Por simularem o produto final, eles podem analisar e processar dados observacionais de maneira eficiente.

Simulações também são ideais para lidar com várias fontes de erros sistemáticos em pesquisas de energia escura. Aparentemente, energia escura age como uma força repulsiva. Mas se inesperadamente, propriedades inconsistentes da energia escura aparecerem nos novos dados ou observações, serão necessárias teorias diferentes e uma forma de validar elas.

“Se você quiser olhar para teorias além da constante cosmológica, você pode fazer predições através de simulações,” diz Heitmann.

Uma forma convencional de testar novas teorias cientificas é introduzir mudanças num sistema e comparar ele com um controle. Mas no caso da cosmologia, nós estamos preso no nosso universo, e o único jeito pelo qual cientistas talvez sejam capaz de descobrir a natureza da energia escura – ao menos no futuro próximo – é usar teorias alternativas em universos virtuais.