Por Christie Aschwanden

Publicado no Five Thirty Eight

Se você acompanha as manchetes, a sua confiança na ciência pode ter levado um golpe recentemente.

Revisão por pares? Mais como auto avaliação. Uma investigação em novembro descobriu uma fraude em que os pesquisadores analisaram seu próprio trabalho, contornando a revisão por pares em cinco editoras de alto nível.

As revistas científicas? Não são exatamente um crachá de legitimidade, dado que o International Journal of Advanced Technology Computer recentemente aceitou para publicação um artigo intitulado “Get Me Off Your Fucking Mailing List” (Me Retire da sua Lista de Mailing de Merda), cujo texto era nada mais do que essas palavras repetidas várias vezes por 10 páginas. Duas outras revistas permitiram que um engenheiro se passasse por Maggie Simpson e Edna Krabappel para publicar um trabalho intitulado “Fuzzy, Homogeneous Configurations” (Configurações Confusas e Homogêneas).

Descobertas revolucionárias? Possivelmente fabricadas. Em maio, dois estudantes de graduação da University of California em Berkeley descobriram irregularidades em um influente artigo de Michael LaCour sugerindo que uma conversa pessoa-a-pessoa com um gay poderia mudar a forma como as pessoas se sentiam a respeito do casamento entre pessoas do mesmo sexo. A revista Science retratou o artigo logo após o co-autor do LaCour não conseguir encontrar nenhum registro dos dados.

Em conjunto, manchetes como estas poderiam sugerir que a ciência é uma empresa obscura que cospe um monte de bobagens com uma roupagem bonitinha. Mas passei meses investigando os problemas que perseguem a ciência, e eu aprendi que os casos anunciados nas manchetes sobre má conduta e fraude são meras distrações. Nossa ciência é forte, mas é atormentada por um problema universal: a ciência é difícil – desgraçadamente difícil.

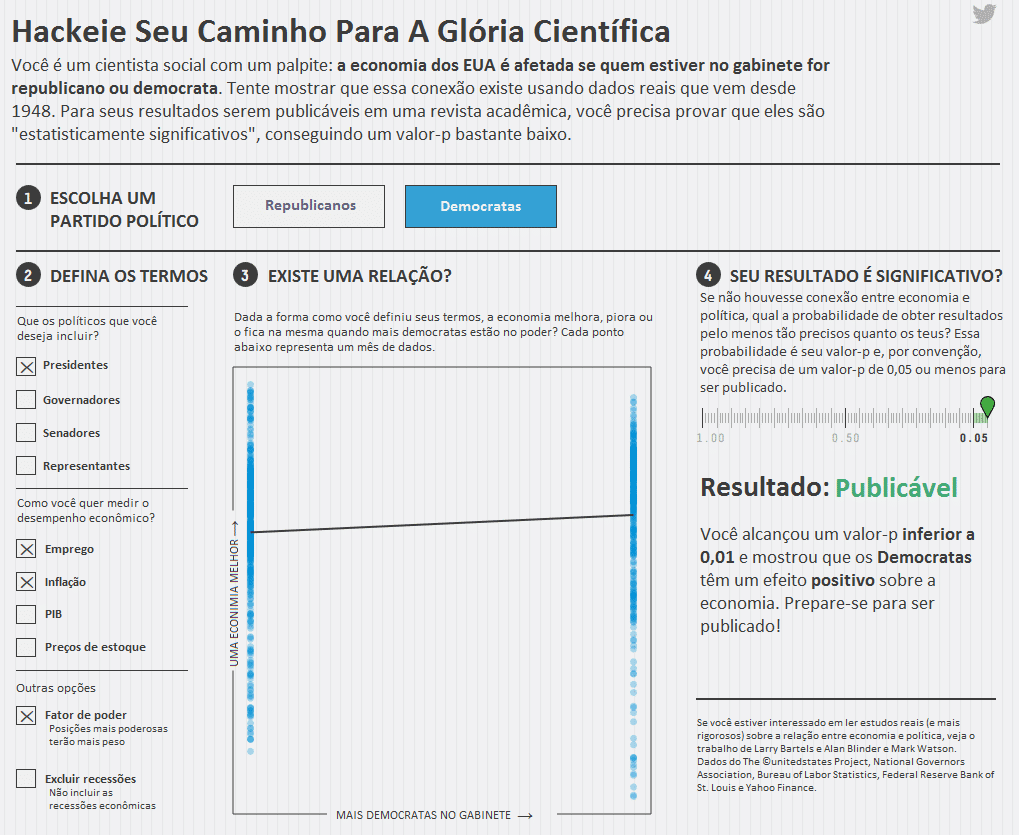

Se nós confiamos na ciência como um meio para alcançar a verdade – e ela ainda é a melhor ferramenta que temos – é importante entendermos e respeitarmos o quão difícil é obter um resultado rigoroso. Eu poderia pontificar sobre todas as razões por que a ciência é árdua, mas em vez disso eu vou deixá-los experimentar um deles por si mesmos. Bem-vindos ao mundo selvagem do p-hacking.

*OBS.: O gráfico interativo do link foi feito para o público americano. A seguir colocamos uma imagem geral com as informações traduzidas.

- Quase lá: Seu valor-p está próximo do limiar de 0,05 (entre 0,1 e 0,06). Tente ajustar suas variáveis para ver se você pode ultrapassar o limite!

- Impublicável: Com esse valor-p (maior que 0,1), os seus resultados não são estatisticamente significativos. Tente definir os seus termos de forma diferente.

Se você ajustou as variáveis e conseguiu provar que os democratas são bons para a economia, parabéns; vá votar na Hillary Clinton com um senso de propósito. Mas não se vanglorie disso aos seus amigos. Você poderia ter alcançado o mesmo resultado com os republicanos.

Os dados em nossa ferramenta interativa podem ser reduzidos e ampliados (p-hacked) para fazer qualquer hipótese parecer correta. Isso porque, mesmo respondendo a uma pergunta científica simples – qual partido está correlacionado com o sucesso econômico – requer grande quantidade de opções capazes de modelar os resultados. Isso não significa que a ciência não é confiável. Significa apenas que ela é mais desafiadora do que nós pensamos.

Qual partido político é melhor para a economia parece ser uma questão bastante simples. Mas como você viu, é muito mais fácil obter um resultado do que obter uma resposta. As variáveis nos conjuntos de dados que você usou para testar sua hipótese tinha 1800 combinações possíveis. Destas, 1078 rendeu o valor-p publicável, mas isso não significa que eles mostraram que o partido em questão tem um forte efeito sobre a economia. A maioria deles não mostrou.

O valor-p revela quase nada sobre a força da evidência, contudo um valor-p de 0,05 se tornou o bilhete para entrar em muitas revistas. “O método dominante utilizado [para avaliar as evidencias] é o valor-p”, disse Michael Evans, um estatístico da Universidade de Toronto, “e o valor-p é bem conhecido por não funcionar muito bem”.

A dependência excessiva dos cientistas sobre os valores-p levou pelo menos uma revista decidir que já estava cansada de tê-los. Em fevereiro, a Basic and Applied Social Psychology anunciou que vai deixar de publicar valores-p. “Acreditamos que a barreira de p<0,05 é muito fácil de passar e às vezes serve como uma desculpa para a pesquisa de qualidade inferior”, escreveram os editores em seu anúncio. Em vez de valores-p, a revista vai exigir “fortes estatísticas descritivas, incluindo tamanhos de efeito”.

Afinal, o que os cientistas realmente querem saber é se sua hipótese é verdadeira, e se assim for, quão forte é a sua descoberta. “Um valor-p não lhes dá isso – nunca lhes dá isso”, disse Regina Nuzzo, estatística e jornalista, em Washington DC, que escreveu sobre o problema do valor-p na Nature no ano passado. Em vez disso, você pode pensar n valor-p como um índice de surpresa. Quão surpreendente seria se os resultados que você defendeu na sua hipótese fossem falsos?

À medida que você manipulava todas essas variáveis no exercício de p-hacking acima, você formou seu resultado, explorando o que os psicólogos Uri Simonsohn, Joseph Simmons e Leif Nelson chamam de “graus de liberdade do pesquisador“, as decisões que os cientistas fazem à medida que realizam um estudo. Estas opções incluem coisas como observações a serem consideradas, com o que você compara, quais os fatores de controle e, no seu caso, se deve medir a economia usando números de emprego ou de inflação (ou ambos). Pesquisadores muitas vezes fazem essas coisas no decorrer das pesquisas e obviamente muitas vezes não há nenhuma maneira correta para prosseguir, o que faz com que seja tentador tentar coisas diferentes até obter o resultado que você está procurando.

Os cientistas que mexem com isso – todos eles fazem, Simonsohn me disse – geralmente não cometem fraudes, essa não é nem a intenção. Eles estão sendo vítimas da tendência humana natural que os levam a inclinar a balança e realizar estudos para produzir resultados falso-positivos.

Desde que a publicação de novos resultados possibilitou angariar recompensas aos cientistas, tais como ocupação e postos de trabalho, há amplo incentivo ao p-hack. Na verdade, quando Simonsohn analisou a distribuição dos valores-p em artigos publicados sobre psicologia, ele descobriu que eles estavam suspeitosamente concentrados em torno de 0,05. “Todo mundo faz p-hacked, pelo menos um pouco”, disse Simonsohn.

Mas isso não significa que os pesquisadores são um bando de mercenários, como LaCour. O que isto significa é que eles são humanos. P-hacking e outros tipos similares de manipulação, muitas vezes surgem a partir de tendências humanos. “Você pode fazer isso de forma inconsciente – eu fiz isso de forma inconsciente”, disse Simonsohn. “Você realmente acredita em sua hipótese e quando você obtém dado não há ambiguidade sobre como analisá-lo”. Quando a primeira tentativa de análise não lhe dá o resultado que você quer, você continua tentando até encontrar um que lhe dê. (E se isso não funcionar, você sempre pode voltar e cair no HARKing – hipotetizar após os resultados serem conhecidos).

Manipulações sutis (ou não tão sutis) como essas atormentam tantos estudos que pesquisador de meta-ciência de Stanford John Ioannidis concluiu, em um famoso artigo de 2005, que a maioria dos resultados de pesquisas são falsos. “É realmente difícil realizar um bom estudo”, ele me disse, admitindo que ele mesmo certamente publicou resultados incorretos também. “Há muitas potenciais tendências, erros e problemas que podem interferir na obtenção de um resultado confiável”. No entanto, apesar dessa conclusão, Ioannidis não largou a ciência. Em vez disso, ele jurou protege-la.

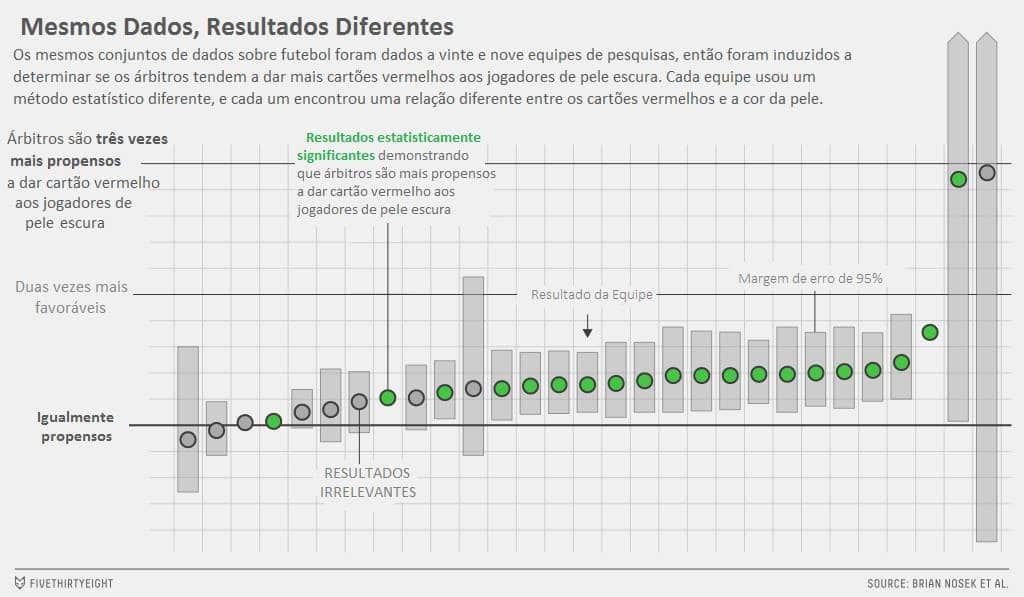

P-hacking é geralmente considerado como trapaça, mas e se nós torna-lo obrigatório? Se o propósito dos estudos é quebrar as fronteiras do conhecimento, então talvez brincar com diferentes métodos não deveria ser considerado como um truque sujo, mas incentivado como uma maneira de explorar as fronteiras. Um projeto recente liderado por Brian Nosek, um dos fundadores Center for Open Science sem fins lucrativos, ofereceu uma maneira inteligente de fazer isso.

A equipe de Nosek convidou pesquisadores para participar de um projeto de análise de dados em crowdsourcing. A configuração foi simples. Foi dado a todos os participantes o mesmo conjunto de dados e perguntaram: “Árbitros de futebol dão mais cartões vermelhos para jogadores de pele escura do que para os de pele clara?”. Eles foram então convidados a apresentar a sua abordagem analítica para o feedback de outras equipes antes de mergulhar na análise.

Vinte e nove equipes com um total de 61 analistas participaram. Os pesquisadores usaram uma ampla variedade de métodos, que vão – para aqueles interessados em metodológica gore – desde de técnicas de regressão linear simples até regressões de vários níveis complexos e abordagens Bayesiana. Eles também tomaram decisões diferentes sobre quais variáveis secundárias usariam em suas análises.

Apesar de analisar os mesmos dados, os pesquisadores tiveram uma variedade de resultados. Vinte equipes concluíram que árbitros de futebol deram mais cartões vermelhos para os jogadores de pele escura, e nove equipes não encontraram nenhuma relação significativa entre cor da pele e cartões vermelhos.

Mas estes resultados diferentes não significam que os estudos nos afastam da verdade. “Por um lado, o nosso estudo mostra que os resultados são fortemente dependentes de escolhas analíticas”, Uhlmann me disse. “Por outro lado, também sugere que a verdade está lá. É difícil olhar para os dados e dizer que não há tendência contra jogadores de pele escura. “Do mesmo modo, você pode testar que a maioria das permutações no estudo da política e da economia produzido, na melhor das hipóteses, são apenas efeitos fracos, o que sugere que, se houver uma relação entre o número de democratas ou republicanos no gabinete e na economia, não é um dado forte.

A lição importante aqui é que uma única análise não é suficiente para encontrar uma resposta definitiva. Cada resultado é uma verdade provisória, que é sujeita a alterações quando alguém aparece para construir, testar e analisar de novo.

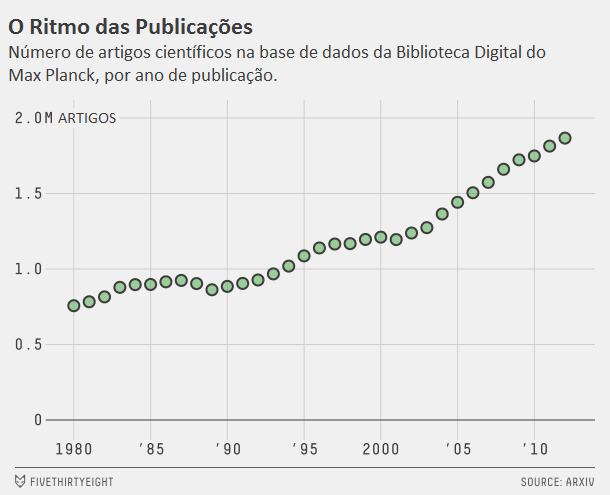

O que torna a ciência tão poderosa é que ela é autocorretiva – com certeza falsos resultados são publicados, mas, eventualmente, novos estudos surgem para derruba-los, e a verdade é revelada. Pelo menos, é assim que deveria funcionar.

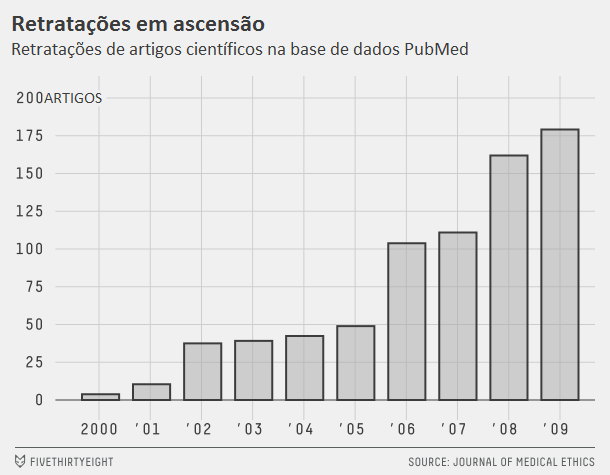

Mas as publicações científicas não têm um grande histórico quando se trata de autocorreção. Em 2010, Ivan Oransky, médico e diretor editorial da MedPage Today, lançou um blog chamado Retraction Watch com Adam Marcus, editor-chefe da Gastroenterology & Endoscopy News e Anesthesiology News. Os dois profissionais se conheceram e tornaram-se amigos enquanto cobriam o caso contra Scott Reuben, um anestesiologista que em 2009 foi pego falsificando dados em pelo menos 21 estudos.

A primeira Retraction Watch foi intitulada “Por que escrever um blog sobre retrações?” Cinco anos depois, a resposta parece evidente: porque sem um esforço conjunto para prestar atenção, ninguém vai notar o que estava errado em primeiro lugar. “Pensei que poderíamos fazer uma publicação por mês”, disse Marcus. “Eu acho que nenhum de nós pensou que iria tornar-se dois ou três por dia”. Mas depois de uma entrevista na rádio pública e a atenção da mídia voltada para a cobertura que o blog fez sobre Marc Hauser, um psicólogo de Harvard pego fabricando dados, as coisas cresceram. “O que ficou claro é que havia um número muito grande de pessoas na ciência que estavam frustrados com a má conduta e a manipulação, e essas pessoas nos encontraram muito rapidamente”, disse Oransky. O site agora atrai 125 mil visualizações por mês.

Embora o site se concentre em retrações e correções, abrange também a má conduta e os erros mais amplos. Mais importante ainda, “é uma plataforma onde as pessoas podem discutir e descobrir casos de fabricação de dados”, disse Daniele Fanelli, cientista de pesquisa sênior da Meta-Research Innovation Center de Stanford. Dicas de leitores ajudaram a criar uma onda de conteúdo, e o site agora emprega vários membros na equipe e está construindo um abrangente banco de dados disponível gratuitamente das retrações com a ajuda de $ 400,000 da bolsa da Fundação MacArthur.

Marcus e Oransky alegam que as retrações não devem ser vistas como uma mancha sobre o empreendimento científico; em vez disso, elas sinalizam que a ciência está consertando seus erros.

Retrações acontecem por uma série de razões, mas plágio e manipulação de imagem (imagens fraudadas de microscópios ou géis, por exemplo, para mostrar os resultados desejados) são os dois mais comuns, disse Marcus. Embora mentiras deslavadas sejam relativamente raras, a maioria dos erros não são apenas erros honestos. Um estudo de 2012 feito pelo microbiologista Ferric Fang da Universidade de Washington e seus colegas concluíram que dois terços das retrações foram devido a má conduta.

A revisão por pares deveria proteger contra a ciência de má qualidade, mas em novembro, Oransky, Marcus e Cat Ferguson, um escritor da Retraction Watch, descobriu um sistema fraudulento da revisão por pares no qual alguns autores exploraram sistemas de computadores dos editores para que eles pudessem rever os seus próprios artigos (e os dos colegas mais próximos).

Mesmo revisores legítimos deixam passar uma abundância de erros. Andrew Vickers é editor de estatística na revista European Urology e bioestatístico no Memorial Sloan Kettering Cancer Center. Há alguns anos atrás, ele decidiu escrever orientações para os contribuintes descrevendo erros estatísticos comuns e como evitá-los. Na preparação para escrever a lista, ele e alguns colegas analisaram artigos que sua revista havia publicado. “Nós tivemos que voltar cerca de 17 artigos até encontramos um sem erro”, ele disse. Sua revista não está sozinha – problemas semelhantes apareceram, disse ele, em anestesia, dor, pediatria e vários outros tipos de revistas.

Muitos usuários simplesmente não verificam os métodos e seções estatísticas de um artigo, e Arthur Caplan, especialista em ética médica da Universidade de Nova York, disse que isso acontece em parte porque eles não são pagos ou recompensados pela revisão por pares de trabalho longos.

Alguns estudos são publicados integralmente sem revisão por pares , e os chamados “editores predadores” inundam a literatura científica com revistas que são essencialmente falsas, publicando qualquer autor que paga. Jeffrey Beall, bibliotecário na Universidade do Colorado em Denver, compilou uma lista com mais de 100 editores predadores de revistas. Essas revistas muitas vezes têm nomes que soam legítimos como o International Journal of Advanced Chemical Research e criam oportunidades para malucos darem às suas opiniões não científicas uma aparência de legitimidade. (Os artigos fakes “get me off your fucking mailing list” e “Simpsons” foram publicados em tais revistas).

Mas a internet está mudando a maneira como os cientistas distribuem e discutem suas ideias e dados, o que pode tornar mais difícil passar artigos de má qualidade como boa ciência. Hoje, quando os investigadores publicam um estudo, os seus pares estão conectados e à disposição para discutir e criticá-lo. Às vezes, comentários inseridos no próprio site da revista sob a forma de “respostas rápidas”, e novos projetos, tais como PubMed Commons e PubPeer fornecem fóruns para revisão rápida pelos pares pós-publicação. As discussões sobre novas publicações também têm lugar em blogs de ciências e mídias sociais, o que pode ajudar a informação sobre os resultados contestados ou corrigidos a se espalhar mais rapidamente.

“Uma das coisas que temos feito incentivado é que cientistas, revistas e universidades parem de agir como se a fraude nunca acontecesse”, disse Oransky. Existem maus jogadores na ciência, assim como há no mundo dos negócios e da política. “A diferença é que a ciência realmente tem um mecanismo de autocorreção. Só que nem sempre funciona. “O papel da Retraction Watched como um cão de guarda forçou mais responsabilidade. O editor do Journal of Biological Chemistry, por exemplo, ficou tão cansado das críticas da Retraction Watched que contratou um gerente de publicações éticas para ajudar seu registro científico tornar-se mais autocorretivo. Retraction Watched colocou revistas em aviso – se eles tentarem retratar artigos sem comentários, eles podem esperar do lado de fora. A discussão das deficiências da ciência tem ido a público.

Após o dilúvio de retratações, histórias de fraudadores, falsos positivos, e as falhas de alto nível para replicar estudos de referência, algumas pessoas começaram a perguntar: “A ciência está falida?“.

Eu passei muitos meses fazendo essa pergunta a dezenas de cientistas, e a resposta que eu encontrei foi um sonoro NÃO. A ciência não está falida, nem é indigna de confiança. É apenas mais difícil do que a maioria de nós imagina. Podemos aplicar mais análise para estudar projetos e exigir estatísticas e métodos analíticos mais cuidadosos, mas isso é apenas uma solução parcial. Para tornar a ciência mais confiável, precisamos ajustar nossas expectativas.

A ciência não é uma varinha mágica que transforma tudo o que toca em verdade. Em vez disso, “a ciência funciona como um processo de redução da incerteza”, disse Nosek, do Center for Open Science. “O objetivo é diminuir os erros ao longo do tempo.” Este conceito é fundamental – o que sabemos agora é apenas a nossa melhor aproximação da verdade. Nós nunca podemos presumir que sabemos tudo.

“Por padrão, nós somos tendemos a encontrar resultados extremos,” Ioannidis disse. As pessoas querem provar alguma coisa, e um resultado negativo não satisfaz esse desejo. O estudo pioneiro de Ioannidis é apenas um que identificou maneiras que os cientistas consciente ou inconscientemente inclinam a balança a favor do resultado eles estão buscando, mas as falhas metodológicas que ele e outros pesquisadores identificaram explicam apenas como os pesquisadores chegam a resultados falsos. Para chegar ao fundo do problema, temos de entender por que estamos tão propensos à nos agarrarmos a ideias erradas. E isso requer o exame de algo mais fundamental: as formas tendenciosas que a mente humana forma crenças.

Algumas dessas tendências são úteis, pelo menos até certo ponto. Tomemos, por exemplo, o realismo ingênuo – a ideia de que qualquer que seja a crença que você tenha, você acredita nisso porque é verdade. Essa mentalidade é quase essencial para fazer ciência, disse o pesquisador de mecânica quântica Seth Lloyd, do MIT. “Você tem que acreditar que o que você está trabalhando agora é a solução para que você tenha a energia e a paixão que você precisa para trabalhar”. Mas as hipóteses costumam estar incorretas, e quando os resultados derrubam uma ideia amada, o pesquisador deve aprender com a experiência e manter, como Lloyd descreveu, “a noção de esperança que ‘OK, talvez essa ideia não estivesse correta, mas a próxima estará'”.

“A ciência é excelente, mas tem baixo rendimento”, disse Fang. “A maioria dos experimentos falham. Isso não significa que o desafio não vale a pena, mas não podemos esperar que cada dólar vire um resultado positivo. A maioria das coisas que você tenta não vinga – isso é apenas a natureza do processo”. Ao invés de simplesmente evitar o fracasso, precisamos almejar a verdade.

No entanto, mesmo em face da esmagadora evidência, é difícil abandonar uma ideia amada, especialmente para um cientista que construiu uma carreira no seu desenvolvimento. E assim, como qualquer um que já tentou corrigir uma falsidade na internet sabe, a verdade nem sempre ganha, pelo menos não inicialmente, porque nós processamos novos elementos de prova através da lente do que nós já acreditamos. A predisposição para a confirmação pode nos cegar para os fatos; somos rápidos para enganar nossas mentes e lentos para alterá-las em face de novas evidências.

Há alguns anos, Ioannidis e alguns colegas reviraram a literatura científica por referências a dois estudos epidemiológicos bem conhecidos que sugerem que suplementos de vitamina E podem proteger contra doenças cardiovasculares. Estes estudos foram seguidos por vários grandes ensaios clínicos randomizados que mostraram nenhum benefício da vitamina E e uma constatação meta-análise que, em altas doses, a vitamina E, na verdade, aumentou o risco de morte.

Apesar das evidências contraditórias dos ensaios mais rigorosos, os primeiros estudos continuaram a ser citados e defendidos na literatura. Reivindicações instáveis sobre a capacidade do betacaroteno de reduzir o risco de câncer e o papel do estrogênio na proteção contra a demência também persistiu, mesmo depois de terem sido revogadas por estudos mais definitivos. Uma vez que uma ideia se torna fixa, é difícil de remove-la da sabedoria convencional.

Às vezes, as ideias científicas persistem além da evidência porque as histórias que contamos sobre elas parecem verdadeiras e confirmam o que já acreditamos. É natural pensar em possíveis explicações para os resultados científicos – é assim que os colocamos no contexto e verificamos sua plausibilidade. O problema surge quando nós caímos de amores por essas explicações que rejeitam a evidência que as refutam.

A mídia é frequentemente acusada de exagerar estudos, mas os cientistas estão propensos a exagerar os seus resultados também.

Tomemos, por exemplo, o estudo sobre o café-da-manhã. Publicado em 2013, ele examinou se as pessoas que consumiam o café-da-manhã pesam menos do que aqueles que pulam essa refeição e se o café-da-manhã pode proteger contra obesidade. O pesquisador de obesidade Andrew Brown e seus colegas descobriram apesar de mais de 90 menções desta hipótese na mídia e em revistas publicadas, a evidência para o efeito do café-da-manhã no peso corporal era tênue e circunstancial. No entanto, pesquisadores da área pareciam cegos para estas deficiências, exagerando as provas e usando uma linguagem causal para descrever associações entre café-da-manhã e obesidade. O cérebro humano está preparado para encontrar causalidade mesmo quando ela não existe, e os cientistas não estão imunes.

Como sociedade, nossas histórias sobre como a ciência funciona também são propensas ao erro. A forma padrão de pensar sobre o método científico é: fazer uma pergunta, fazer um estudo, obter uma resposta. Mas essa noção é muito simplista. Um caminho mais comum para a verdade se parece com isso: fazer uma pergunta, fazer um estudo, obter uma resposta parcial ou ambígua, em seguida fazer um outro estudo, e depois fazer outro para continuar testando as potenciais hipóteses e procurar uma resposta mais completa. As falibilidades humanas afogam o processo científico em encaixes, começos e descaminhos em vez de traçar uma linha reta desde a questão até a verdade.

Relatos da imprensa da ciência tendem a encobrir a nuance, e é fácil entender o porquê. Por um lado, repórteres e editores que cobrem ciência nem sempre têm formação sobre como interpretar estudos. E manchetes que dizem “estudo fraco não replicado encontra a ligação tênue entre certos vegetais e o risco de câncer” não voam das prateleiras ou trazem cliques tão rápido quanto aqueles que gritam “alimentos que combatem o câncer!”.

As pessoas costumam brincar com a natureza “bipolar” da ciência e da saúde nas manchetes da mídia – o café é bom para você num dia e ruim no dia seguinte – mas isso mostra exatamente que o processo científico é tudo. É difícil medir o impacto da dieta sobre a saúde, Nosek disse. “Essa variação [no resultado] ocorre porque a ciência é difícil”. Isolar como o café afeta a saúde requer muito estudo e muita evidência, e apenas ao longo do tempo e ao longo de muitos e muitos estudos é que as provas vão começar a limitar uma conclusão defensável. “A variação de resultados não deve ser vista como uma ameaça”, disse Nosek. “Isso significa que os cientistas estão trabalhando em um problema difícil”.

O método científico é o caminho mais rigoroso para o conhecimento, mas também é confuso e difícil. A ciência merece respeito exatamente porque é difícil – não porque fica tudo certo na primeira tentativa. A incerteza inerente a ciência não significa que não podemos usá-la para fazer políticas ou decisões importantes. Isso apenas significa que devemos manter a cautela e adotar uma mentalidade aberta a mudança se novos dados surgirem. Devemos tomar as melhores decisões que pudermos com as evidências atuais e tomar cuidado para não perder de vista a força e grau de certeza. Não é por acaso que todo bom artigo inclui a frase “mais estudos são necessários” – há sempre mais para aprender.

*Tradução em cooperação com Caroline Fagundes.