Por Matthew Hutson

Publicado na Science

Ali Rahimi, um pesquisador de inteligência artificial no Google de São Francisco, Califórnia, atacou a sua área em dezembro passado – e recebeu uma ovação de 40 segundos em resposta. Falando em uma conferência de IA, Rahimi afirmou que algoritmos de “machine learning”, nos quais a máquina aprende por tentativa e erro, se tornaram uma forma de “alquimia”. Pesquisadores, segundo ele, não sabem porque alguns algoritmos funcionam e outros não, tampouco possuem critérios rigorosos para a escolha de uma arquitetura de IA ao invés de outra. Agora, em um artigo apresentado em 30 de abril na International Conference on Learning Representations em Vancouver, Canada Rahimi e seus colaboradores documentaram exemplos do que eles veem como “o problema alquímico” e ofereceram soluções para fortalecer o rigor das IAs.

“Há uma angustia na área”, disse Rahimi. “Muitos de nós sentimos como se estivéssemos operando tecnologia alienígena”.

A questão é distinta do problema de reprodutibilidade na área de IAs, onde pesquisadores não conseguem replicar os resultados uns dos outros por causa de práticas inconsistentes de experimentação e publicação. Também difere da “caixa preta” ou problema da “interpretabilidade” na machine learning: a dificuldade de explicar como uma IA em particular chegou à sua conclusão. Como Rahimi coloca, “estou tentando fazer uma distinção entre um sistema de machine learning que se tornou uma caixa preta e uma área inteira que se tornou uma caixa preta”.

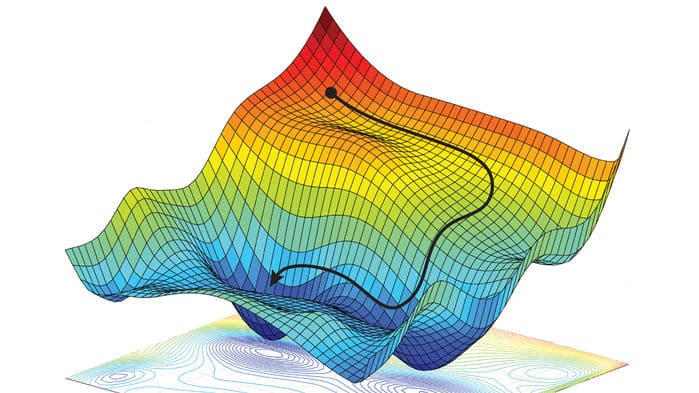

Sem uma compreensão profunda das ferramentas básicas necessárias para construir e treinar algoritmos, ele diz, pesquisadores criando IAs recorrem a boatos, como alquimistas medievais. “Pessoas gravitam ao redor de práticas de culto”, dependendo de “folclore e magias”, adicionou François Chollet, um cientista de computadores da Google. Por exemplo, ele diz, eles adotam métodos preferidos para aperfeiçoar a “taxa de aprendizado” de suas IAs – o quanto um algoritmo corrige a si próprio a cada erro – sem entender porque alguns são melhores que outros. Em outros casos, pesquisadores de IA treinando seus algoritmos estão apenas tateando no escuro. Por exemplo, eles implementam o que é chamado de “descida de gradiente estocástico” para otimizar os parâmetros de um algoritmo com a menor taxa de erro possível. E apesar de milhares de artigos acadêmicos sobre o assunto, e incontáveis formas de aplicar o método, o processo ainda depende de tentativa e erro.

O artigo de Rahimi realça o esforço desperdiçado e a performance sub-ótima que isso pode resultar. Por exemplo, o artigo nota que quando outros pesquisadores tiraram fora boa parte da complexidade de um algoritmo de tradução topo-de-linha, ele conseguiu traduzir ainda melhor e de forma mais eficiente do inglês para o francês ou alemão, mostrando que seus criadores não haviam entendido de fato para que serviam aquelas partes extras. Inversamente, às vezes os “enfeites” colocados em um algoritmo são as únicas partes boas, diz Ferenc Huszár, um pesquisador de machine learning do Twitter. Em alguns casos, ele diz, o núcleo de um algoritmo é tecnicamente falho, implicando que os seus bons resultados são “atribuíveis inteiramente à outros truques aplicados em cima”.

Rihami oferece diversas sugestões para aprender que algoritmos funcionam melhor, e quando. Para começo de conversa, ele diz, pesquisadores devem conduzir “estudos de ablação” como aqueles feitos no algoritmo de tradução: deletar partes do algoritmo uma por vez para ver a função de cada componente. Ele clama por uma “análise em fatias”, na qual a performance de um algoritmo é analisada em detalhe para ver se melhorias em algumas áreas podem ter custos em outras. E ele diz que pesquisadores devem testar seus algoritmos em muitas condições e configurações diferentes, e reportar a performance em todas.

Ben Recht, um cientista de computadores na University of California, Berkeley, e coautor da apresentação de Rahimi onde a afirmação sobre alquimia foi feita, afirmou que IA precisa se inspirar na Física, onde pesquisadores comumente reduzem problemas à um “problema brinquedo” muito menor. “Físicos são fantásticos em desenvolver experimentos simples para erradicar problemas complexos” ele diz. Alguns pesquisadores de IA começaram a usar essa abordagem, testando algoritmos de reconhecimento de imagem em pequenos caracteres em preto-e-branco escritos à mão antes de encarar grandes imagens coloridas, para melhor compreender os mecanismos internos do algoritmo.

Csaba Szepesvári, um cientista de computadores da DeepMind, em Londres, diz que a área precisa reduzir sua ênfase em testes competitivos. No presente, um artigo tem mais chance de ser publicado se o algoritmo reportado superar um benchmark do que se o artigo iluminar o funcionamento interno do algoritmo, ele diz. É assim que aquele algoritmo de tradução “chique” passou pela revisão por pares. “O propósito da ciência é gerar conhecimento” ele diz. “Você quer produzir algo que outras pessoas possam tomar e aperfeiçoar”.

Nem todos concordam com as críticas de Rahimi e Recht. Yann LeCun, chefe de IA do Facebook, se preocupa que mudar demais o ênfase da área, do desenvolvimento de técnicas de ponta para o ênfase em conhecimento e compreensão, pode retardar a inovação e desencorajar a adoção de IAs no mundo real. “Não é alquimia, é engenharia” ele diz. “Engenharia bagunçada”.

Recht enxerga lugar tanto para pesquisadores metódicos quanto aventureiros. “Nós precisamos de ambos” ele diz. “Nós precisamos entender onde pontos de falhas surgem para poder construir sistemas confiáveis, e precisamos empurrar as fronteiras para que possamos ter sistemas ainda mais impressionantes mais à frente”.